Moin,

ich habe heute einen neuen Node (Nummer 4) in das Cluster gehoben.

Habe ihn dann in die HA Gruppe gehoben und die Replizierungen eingerichtet.

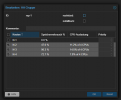

Nun habe ich den aktualisiert und neu gestartet und sehe, dass auf einmal alle einfach mit neustarten.

Das ist neu. Wie kann ich das verhindern? Liegt das vllt an der HA Gruppe?

Eine zweite kleine Frage.

Wie kann ich das Cluster optimal erreichbar und produktiv machen? Aktuell rufe ich es über einen Node auf (Webgui). Wenn ich den aber neu starte, muss ich ja die IP wechseln.

Möchte gerne, dass ich die Informationen über alle Nodes, VMs und Co. möglichst live sehe und nicht lange diese Fragezeichen. Wie löst ihr das? Mit einem PI und der übernimmt dann diese Rolle? Aktuell sind all meine 4 Nodes kleine intel CPU Server.

LG

ich habe heute einen neuen Node (Nummer 4) in das Cluster gehoben.

Habe ihn dann in die HA Gruppe gehoben und die Replizierungen eingerichtet.

Nun habe ich den aktualisiert und neu gestartet und sehe, dass auf einmal alle einfach mit neustarten.

Das ist neu. Wie kann ich das verhindern? Liegt das vllt an der HA Gruppe?

Eine zweite kleine Frage.

Wie kann ich das Cluster optimal erreichbar und produktiv machen? Aktuell rufe ich es über einen Node auf (Webgui). Wenn ich den aber neu starte, muss ich ja die IP wechseln.

Möchte gerne, dass ich die Informationen über alle Nodes, VMs und Co. möglichst live sehe und nicht lange diese Fragezeichen. Wie löst ihr das? Mit einem PI und der übernimmt dann diese Rolle? Aktuell sind all meine 4 Nodes kleine intel CPU Server.

LG

Last edited: