Hallo,

ich möchte meinen PVE 8.3 neu aufsetzen. Mich würden Meinungen bezüglich des Dateisystems interessieren.

CPU: 48 x Intel Xeon Gold 5412U (1 Socket)

SSDs: 4x 1,92 TB NVMe-Datacenter SSDs

Es laufen ein paar Debian 12- und ein paar Windows 11/Server 2022-Maschinen. Gerade bei den Windows-Geräten wirkt der Zugriff auf den Windows-Explorer recht langsam (alle mit VirtIO single).

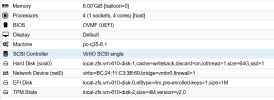

Ich hatte mich damals wohl für ZFS RAID-Z2 entschieden... oder lese ich das falsch?

Belegt sind gerade einmal 750GB. RAM ist viel frei, Snapshots und Replikation benutze ich nicht.

Ich tendiere nun zu LVM mit RAID 10. Weil womöglich etwas mehr Performance, und die Vorteile von ZFS nutze ich nicht.

Was meint Ihr?

Oliver

ich möchte meinen PVE 8.3 neu aufsetzen. Mich würden Meinungen bezüglich des Dateisystems interessieren.

CPU: 48 x Intel Xeon Gold 5412U (1 Socket)

SSDs: 4x 1,92 TB NVMe-Datacenter SSDs

Es laufen ein paar Debian 12- und ein paar Windows 11/Server 2022-Maschinen. Gerade bei den Windows-Geräten wirkt der Zugriff auf den Windows-Explorer recht langsam (alle mit VirtIO single).

Ich hatte mich damals wohl für ZFS RAID-Z2 entschieden... oder lese ich das falsch?

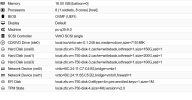

Code:

root@proxmox:~# zpool status

pool: rpool

state: ONLINE

scan: scrub repaired 0B in 00:05:17 with 0 errors on Tue Nov 19 17:40:42 2024

config:

NAME STATE READ WRITE CKSUM

rpool ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

nvme-eui.36344730528022380025384500000001-part3 ONLINE 0 0 0

nvme-eui.3634473054b030920025385300000001-part3 ONLINE 0 0 0

mirror-1 ONLINE 0 0 0

nvme-eui.36344730525126400025384500000001-part3 ONLINE 0 0 0

nvme-eui.3634473054b030170025385300000001-part3 ONLINE 0 0 0

errors: No known data errorsBelegt sind gerade einmal 750GB. RAM ist viel frei, Snapshots und Replikation benutze ich nicht.

Ich tendiere nun zu LVM mit RAID 10. Weil womöglich etwas mehr Performance, und die Vorteile von ZFS nutze ich nicht.

Was meint Ihr?

Oliver