Hallo Zusammen,

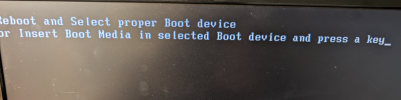

ich hatte jetzt das zweite mal in 5 Tagen das der Server nicht mehr erreichbar war. Am Monitor war dann folgende Meldung zu sehen:

"Reboot and Select proper Boot devide

or Insert Boot Media in selected Boot device and press a key".

Wenn ich dann den Server einfach nochmal ein- ausschalte bootet er normal und es funktioniert auch alles wieder.

Nun die Frage warum bootet er überhaupt und wenn er schon bootet warum findet er anscheinend beim ersten Versuch seine Bootplatte nicht?

Ich habe hier mal die beiden Logs for dem Reboot, bin aber sehr schlecht am deuten. Vielleicht ist der Reboot auch aufgrund irgendeines Task notwendig und es gibt nicht wirklich ein Problem? Der Server lief jetzt aber über Monate einwandfrei und fing erst jetzt mit dem Thema an. Irgendwelche großen Dinge habe ich auch nicht konfiguriert, alles ziemlich einfach gehalten.... ein Handvoll VMs laufen und Backups sind eingerichtet.

Reboot vom 29.05:

Reboot vom 02.06:

Hat jemand eine Idee was das sein könnte? Evtl. auch ein Hardwaredefekt z.B. Memory möglich? Die gesamte Hardware mit Außnahme des Netzteils wurde erst im März gekauft.

ich hatte jetzt das zweite mal in 5 Tagen das der Server nicht mehr erreichbar war. Am Monitor war dann folgende Meldung zu sehen:

"Reboot and Select proper Boot devide

or Insert Boot Media in selected Boot device and press a key".

Wenn ich dann den Server einfach nochmal ein- ausschalte bootet er normal und es funktioniert auch alles wieder.

Nun die Frage warum bootet er überhaupt und wenn er schon bootet warum findet er anscheinend beim ersten Versuch seine Bootplatte nicht?

Ich habe hier mal die beiden Logs for dem Reboot, bin aber sehr schlecht am deuten. Vielleicht ist der Reboot auch aufgrund irgendeines Task notwendig und es gibt nicht wirklich ein Problem? Der Server lief jetzt aber über Monate einwandfrei und fing erst jetzt mit dem Thema an. Irgendwelche großen Dinge habe ich auch nicht konfiguriert, alles ziemlich einfach gehalten.... ein Handvoll VMs laufen und Backups sind eingerichtet.

Reboot vom 29.05:

Code:

May 29 00:00:12 pve systemd[1]: Starting dpkg-db-backup.service - Daily dpkg database backup service...

May 29 00:00:12 pve systemd[1]: Starting logrotate.service - Rotate log files...

May 29 00:00:12 pve systemd[1]: dpkg-db-backup.service: Deactivated successfully.

May 29 00:00:12 pve systemd[1]: Finished dpkg-db-backup.service - Daily dpkg database backup service.

May 29 00:00:12 pve systemd[1]: Reloading pveproxy.service - PVE API Proxy Server...

May 29 00:00:13 pve pveproxy[2706374]: send HUP to 1866

May 29 00:00:13 pve pveproxy[1866]: received signal HUP

May 29 00:00:13 pve pveproxy[1866]: server closing

May 29 00:00:13 pve pveproxy[1866]: server shutdown (restart)

May 29 00:00:13 pve systemd[1]: Reloaded pveproxy.service - PVE API Proxy Server.

May 29 00:00:13 pve systemd[1]: Reloading spiceproxy.service - PVE SPICE Proxy Server...

May 29 00:00:13 pve spiceproxy[2706376]: send HUP to 1872

May 29 00:00:13 pve spiceproxy[1872]: received signal HUP

May 29 00:00:13 pve spiceproxy[1872]: server closing

May 29 00:00:13 pve spiceproxy[1872]: server shutdown (restart)

May 29 00:00:13 pve systemd[1]: Reloaded spiceproxy.service - PVE SPICE Proxy Server.

May 29 00:00:13 pve pvefw-logger[1968228]: received terminate request (signal)

May 29 00:00:13 pve pvefw-logger[1968228]: stopping pvefw logger

May 29 00:00:13 pve systemd[1]: Stopping pvefw-logger.service - Proxmox VE firewall logger...

May 29 00:00:13 pve spiceproxy[1872]: restarting server

May 29 00:00:13 pve spiceproxy[1872]: starting 1 worker(s)

May 29 00:00:13 pve spiceproxy[1872]: worker 2706384 started

May 29 00:00:13 pve systemd[1]: pvefw-logger.service: Deactivated successfully.

May 29 00:00:13 pve systemd[1]: Stopped pvefw-logger.service - Proxmox VE firewall logger.

May 29 00:00:13 pve systemd[1]: pvefw-logger.service: Consumed 5.272s CPU time.

May 29 00:00:13 pve systemd[1]: Starting pvefw-logger.service - Proxmox VE firewall logger...

May 29 00:00:13 pve pvefw-logger[2706387]: starting pvefw logger

May 29 00:00:13 pve systemd[1]: Started pvefw-logger.service - Proxmox VE firewall logger.

May 29 00:00:13 pve systemd[1]: logrotate.service: Deactivated successfully.

May 29 00:00:13 pve systemd[1]: Finished logrotate.service - Rotate log files.

May 29 00:00:13 pve pveproxy[1866]: Using '/etc/pve/local/pveproxy-ssl.pem' as certificate for the web interface.

May 29 00:00:13 pve pveproxy[1866]: restarting server

May 29 00:00:13 pve pveproxy[1866]: starting 3 worker(s)

May 29 00:00:13 pve pveproxy[1866]: worker 2706392 started

May 29 00:00:13 pve pveproxy[1866]: worker 2706393 started

May 29 00:00:13 pve pveproxy[1866]: worker 2706394 started

May 29 00:00:18 pve spiceproxy[1968225]: worker exit

May 29 00:00:18 pve spiceproxy[1872]: worker 1968225 finished

May 29 00:00:18 pve pveproxy[1968234]: worker exit

May 29 00:00:18 pve pveproxy[1968233]: worker exit

May 29 00:00:18 pve pveproxy[1968232]: worker exit

May 29 00:00:18 pve pveproxy[1866]: worker 1968234 finished

May 29 00:00:18 pve pveproxy[1866]: worker 1968233 finished

May 29 00:00:18 pve pveproxy[1866]: worker 1968232 finished

May 29 00:17:01 pve CRON[2717204]: pam_unix(cron:session): session opened for user root(uid=0) by (uid=0)

May 29 00:17:01 pve CRON[2717205]: (root) CMD (cd / && run-parts --report /etc/cron.hourly)

May 29 00:17:01 pve CRON[2717204]: pam_unix(cron:session): session closed for user root

\-- Reboot --Reboot vom 02.06:

Code:

Jun 02 05:02:21 pve pvedaemon[2823681]: <root@pam> successful auth for user 'root@pam'

Jun 02 05:17:01 pve CRON[2848023]: pam_unix(cron:session): session opened for user root(uid=0) by (uid=0)

Jun 02 05:17:01 pve CRON[2848024]: (root) CMD (cd / && run-parts --report /etc/cron.hourly)

Jun 02 05:17:01 pve CRON[2848023]: pam_unix(cron:session): session closed for user root

Jun 02 05:17:22 pve pvedaemon[2814674]: <root@pam> successful auth for user 'root@pam'

Jun 02 05:17:45 pve pvedaemon[2814674]: worker exit

Jun 02 05:17:45 pve pvedaemon[1851]: worker 2814674 finished

Jun 02 05:17:45 pve pvedaemon[1851]: starting 1 worker(s)

Jun 02 05:17:45 pve pvedaemon[1851]: worker 2848331 started

Jun 02 05:29:09 pve smartd[1425]: Device: /dev/sdd [SAT], SMART Prefailure Attribute: 1 Raw_Read_Error_Rate changed from 69 to 72

Jun 02 05:29:09 pve smartd[1425]: Device: /dev/sdd [SAT], SMART Usage Attribute: 190 Airflow_Temperature_Cel changed from 71 to 70

Jun 02 05:29:09 pve smartd[1425]: Device: /dev/sdd [SAT], SMART Usage Attribute: 194 Temperature_Celsius changed from 29 to 30

Jun 02 05:29:46 pve pveproxy[2830439]: worker exit

Jun 02 05:29:46 pve pveproxy[1860]: worker 2830439 finished

Jun 02 05:29:46 pve pveproxy[1860]: starting 1 worker(s)

Jun 02 05:29:46 pve pveproxy[1860]: worker 2853963 started

Jun 02 05:31:14 pve pveproxy[2826868]: worker exit

Jun 02 05:31:14 pve pveproxy[1860]: worker 2826868 finished

Jun 02 05:31:14 pve pveproxy[1860]: starting 1 worker(s)

Jun 02 05:31:14 pve pveproxy[1860]: worker 2854676 started

Jun 02 05:32:22 pve pvedaemon[2824855]: <root@pam> successful auth for user 'root@pam'

Jun 02 05:39:18 pve pvedaemon[2823681]: worker exit

Jun 02 05:39:18 pve pvedaemon[1851]: worker 2823681 finished

Jun 02 05:39:18 pve pvedaemon[1851]: starting 1 worker(s)

Jun 02 05:39:18 pve pvedaemon[1851]: worker 2858459 started

Jun 02 05:46:24 pve pvedaemon[2824855]: worker exit

Jun 02 05:46:24 pve pvedaemon[1851]: worker 2824855 finished

Jun 02 05:46:24 pve pvedaemon[1851]: starting 1 worker(s)

Jun 02 05:46:24 pve pvedaemon[1851]: worker 2861737 started

Jun 02 05:47:23 pve pvedaemon[2858459]: <root@pam> successful auth for user 'root@pam'

Jun 02 05:47:32 pve pveproxy[2835817]: worker exit

Jun 02 05:47:32 pve pveproxy[1860]: worker 2835817 finished

Jun 02 05:47:32 pve pveproxy[1860]: starting 1 worker(s)

Jun 02 05:47:32 pve pveproxy[1860]: worker 2862276 started

Jun 02 05:59:09 pve smartd[1425]: Device: /dev/sdd [SAT], SMART Usage Attribute: 190 Airflow_Temperature_Cel changed from 70 to 71

Jun 02 05:59:09 pve smartd[1425]: Device: /dev/sdd [SAT], SMART Usage Attribute: 194 Temperature_Celsius changed from 30 to 29

Jun 02 06:02:23 pve pvedaemon[2858459]: <root@pam> successful auth for user 'root@pam'

Jun 02 06:03:58 pve systemd[1]: Starting apt-daily.service - Daily apt download activities...

Jun 02 06:03:58 pve systemd[1]: apt-daily.service: Deactivated successfully.

Jun 02 06:03:58 pve systemd[1]: Finished apt-daily.service - Daily apt download activities.

-- Reboot --Hat jemand eine Idee was das sein könnte? Evtl. auch ein Hardwaredefekt z.B. Memory möglich? Die gesamte Hardware mit Außnahme des Netzteils wurde erst im März gekauft.