Hallo zusammen,

Ich nutze die aktuelle PVE-Version und habe eine VM von Open Media Vault installiert und dort eine NVME (WD RED 700, 2 Gbyte) an OMV durchgereicht und dort mit ext4 formatiert.

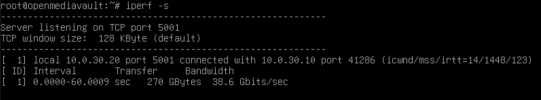

Ich erinnere mich daran, dass ich damals, als ich die NVMe frisch installiert hatte, über eine NFS-Freigabe (Freigabe über Mount und durchreichen an den LXC) eine Leseleitung von über 400 Mbyte hatte.

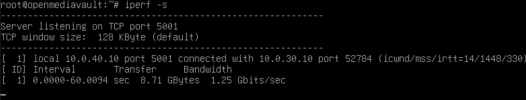

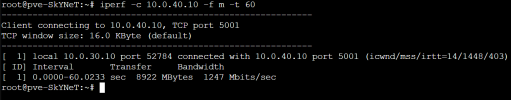

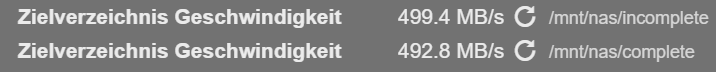

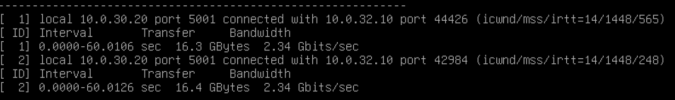

Jetzt habe ich die Container etc. in neu verteilt und über die 2 NICs im VLAN gepackt. HAbe dann noch einmal getestet und bekommen, egal was ich mache, nicht mehr als 130 bis 150 Mbyte die sekunde.

Nun die Frage, warum der Leistungseinbruch? Hat trim auch mit der Leseleistung, oder nur mit der Schreibleistung zu tun? Ich hatte bisher kein Discard und keine SSD-Emulation an, habe dies aber jetzt nachgeholt. Nun die Frage, Trimmt OMV dann automatisch? Muss ich in der VM trimmen oder über den Host?

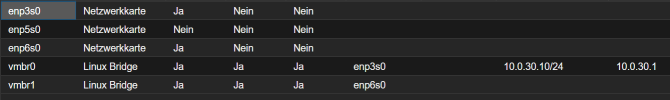

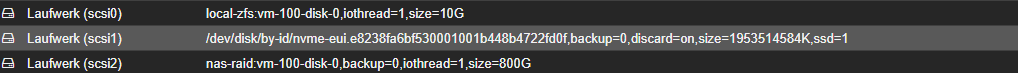

So ist die NVME eingebaut:

Danke und Grüße

Ich nutze die aktuelle PVE-Version und habe eine VM von Open Media Vault installiert und dort eine NVME (WD RED 700, 2 Gbyte) an OMV durchgereicht und dort mit ext4 formatiert.

Ich erinnere mich daran, dass ich damals, als ich die NVMe frisch installiert hatte, über eine NFS-Freigabe (Freigabe über Mount und durchreichen an den LXC) eine Leseleitung von über 400 Mbyte hatte.

Jetzt habe ich die Container etc. in neu verteilt und über die 2 NICs im VLAN gepackt. HAbe dann noch einmal getestet und bekommen, egal was ich mache, nicht mehr als 130 bis 150 Mbyte die sekunde.

Nun die Frage, warum der Leistungseinbruch? Hat trim auch mit der Leseleistung, oder nur mit der Schreibleistung zu tun? Ich hatte bisher kein Discard und keine SSD-Emulation an, habe dies aber jetzt nachgeholt. Nun die Frage, Trimmt OMV dann automatisch? Muss ich in der VM trimmen oder über den Host?

So ist die NVME eingebaut:

Danke und Grüße