Hallo liebe Community,

nach längerer Zeit wende ich mich mit einer neuen Herausforderung vor der ich stehe an euch.

Ich möchte gerne meinen Computer aufspalten in mehrere virtuelle Computer.

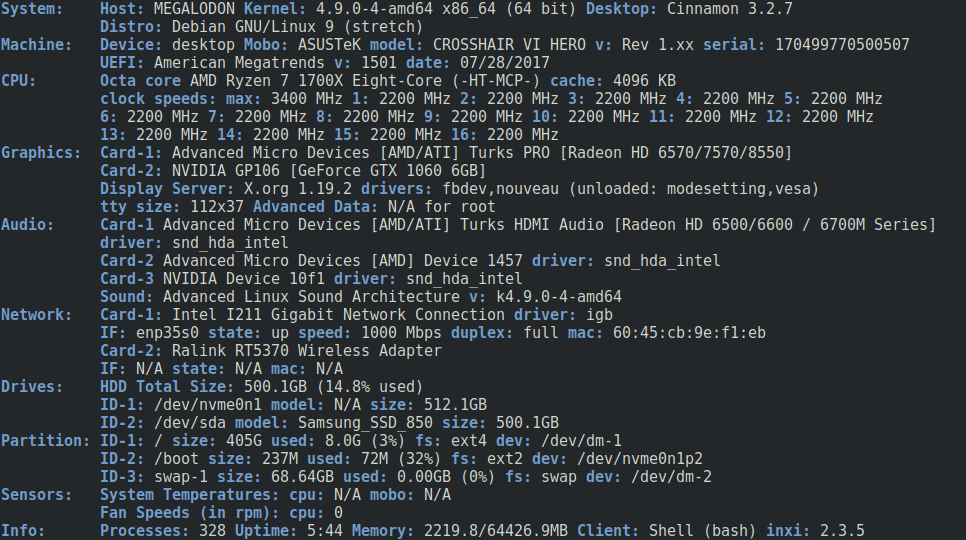

Folgende Hardware ist verbaut:

ASUS Crosshair VI Hero, Socket AM4

AMD Ryzen 1700X 8c/16t

64GB DDR4-2400 Crucial Ballistix Sport

Samsung 960 Pro 512GB NVMe

Samsung 950 Evo 500GB SATA

Intel I211 1Gb NIC (Mainboard)

GTX 1060 6G OC

Radeon HD 6570 2G

Diverse Kärtchen wie eine Elgato HD60 Pro, ...

Am liebsten wären mir eine VM zum Arbeiten und eine zum Spielen, ich habe jedoch gelesen, dass ich eine GPU für den Host brauche. Schade eigentlich. Eine dritte GraKa zu verbauen wird schwer, da gehen mir bald die Slots aus. Und die Karten.

Ich habe jedoch gelesen, dass man auch den Proxmox Host mit einem Desktop ausstatten kann und quasi als hybride Workstation nutzen kann.

Nicht ganz ideal mMn. aber auf jeden Fall schon mal nicht schlecht!

Für den Proxmox Host würde ich gerne die Radeon als GPU nutzen - die lag im Regal rum und kann nicht allzu viel im Vergleich zu moderner Hardware, jedoch reicht sie für alle Tasks außer Computing und Gaming aufs Vollste!

Die Geforce soll per PCI Passthrough an die Gaming VM weitergereicht werden.

Beide GPUs sind am Ende jeweils mit 2 HDMI Anschlüssen an eine 4x2 HDMI Matrix angeschlossen, sodass ich jeweils die gewünschten VMs auf meine 2 Bildschirme legen kann.

Tastatur, Maus und sogar das Clipboard will ich mit Hilfe der Software "Synergy Pro" beiden Maschinen zugänglich machen.

Beide Maschinen kriegen natürlich noch ein paar weitere Systemressourcen und etwas Storage auf beiden SSDs. Rest wird per Netzwerk angebunden.

Mein erster Versuch war eigentlich mit ESXi 6.7 - Fehlschlag. Das GPU Passthrough lief hinten und vorne nicht korrekt.

unRAID wird genau für sowas beworben... ich will aber nicht noch mehr Geld für das Projekt ausgeben, wenn es nicht sein muss - außerdem kommt mir diese abgewandelte RAID-4 Konstellation worauf die setzen etwas spanisch vor. Herstellerspezifischer Krims - bäh.

Proxmox benutze ich momentan seit ein paar Monaten auf 2 Servern mit größtem Erfolg.

Und nunja.. darum schaue ich nun wie sich PVE bei dieser Aufgabe schlagen kann.

Nun zu dem eigentlich Grund des Threads...

Die Probleme ließen nämlich nicht lange auf sich warten... die Netzwerkkarte kriegt keine Verbindung.

Nicht mal das Gateway lässt sich anpingen. Unter Debian Live, ESXi und Windows 10 treten diese Probleme nicht auf.

Auch steht nichtmal der Befehl ifconfig zur Verfügung - sehr merkwürdig.

Ich habe übrigens das offizielle ISO zur Installation genutzt.

Kernelversion

Linux 4.15.17-1-pve #1 SMP PVE 4.15.17-9 (Wed, 9 May 2018 13:31:43 +0200)

PVE Manager Version

pve-manager/5.2-1/0fcd7879

Wäre um jede Hilfe dankbar!

Damit ließe sich richtig was rausholen aus der Kiste.

Ich werde den Thread zukünftig auch mit weiteren Updates bestücken, immer wenn ich irgendwo voran komme.

Und natürlich mit weiteren Fragen, falls sich neue Probleme auftürmen; bin gespannt ob sich jemand für solch eine Spielerei interessiert. =)

nach längerer Zeit wende ich mich mit einer neuen Herausforderung vor der ich stehe an euch.

Ich möchte gerne meinen Computer aufspalten in mehrere virtuelle Computer.

Folgende Hardware ist verbaut:

ASUS Crosshair VI Hero, Socket AM4

AMD Ryzen 1700X 8c/16t

64GB DDR4-2400 Crucial Ballistix Sport

Samsung 960 Pro 512GB NVMe

Samsung 950 Evo 500GB SATA

Intel I211 1Gb NIC (Mainboard)

GTX 1060 6G OC

Radeon HD 6570 2G

Diverse Kärtchen wie eine Elgato HD60 Pro, ...

Am liebsten wären mir eine VM zum Arbeiten und eine zum Spielen, ich habe jedoch gelesen, dass ich eine GPU für den Host brauche. Schade eigentlich. Eine dritte GraKa zu verbauen wird schwer, da gehen mir bald die Slots aus. Und die Karten.

Ich habe jedoch gelesen, dass man auch den Proxmox Host mit einem Desktop ausstatten kann und quasi als hybride Workstation nutzen kann.

Nicht ganz ideal mMn. aber auf jeden Fall schon mal nicht schlecht!

Für den Proxmox Host würde ich gerne die Radeon als GPU nutzen - die lag im Regal rum und kann nicht allzu viel im Vergleich zu moderner Hardware, jedoch reicht sie für alle Tasks außer Computing und Gaming aufs Vollste!

Die Geforce soll per PCI Passthrough an die Gaming VM weitergereicht werden.

Beide GPUs sind am Ende jeweils mit 2 HDMI Anschlüssen an eine 4x2 HDMI Matrix angeschlossen, sodass ich jeweils die gewünschten VMs auf meine 2 Bildschirme legen kann.

Tastatur, Maus und sogar das Clipboard will ich mit Hilfe der Software "Synergy Pro" beiden Maschinen zugänglich machen.

Beide Maschinen kriegen natürlich noch ein paar weitere Systemressourcen und etwas Storage auf beiden SSDs. Rest wird per Netzwerk angebunden.

Mein erster Versuch war eigentlich mit ESXi 6.7 - Fehlschlag. Das GPU Passthrough lief hinten und vorne nicht korrekt.

unRAID wird genau für sowas beworben... ich will aber nicht noch mehr Geld für das Projekt ausgeben, wenn es nicht sein muss - außerdem kommt mir diese abgewandelte RAID-4 Konstellation worauf die setzen etwas spanisch vor. Herstellerspezifischer Krims - bäh.

Proxmox benutze ich momentan seit ein paar Monaten auf 2 Servern mit größtem Erfolg.

Und nunja.. darum schaue ich nun wie sich PVE bei dieser Aufgabe schlagen kann.

Nun zu dem eigentlich Grund des Threads...

Die Probleme ließen nämlich nicht lange auf sich warten... die Netzwerkkarte kriegt keine Verbindung.

Nicht mal das Gateway lässt sich anpingen. Unter Debian Live, ESXi und Windows 10 treten diese Probleme nicht auf.

Auch steht nichtmal der Befehl ifconfig zur Verfügung - sehr merkwürdig.

Ich habe übrigens das offizielle ISO zur Installation genutzt.

Kernelversion

Linux 4.15.17-1-pve #1 SMP PVE 4.15.17-9 (Wed, 9 May 2018 13:31:43 +0200)

PVE Manager Version

pve-manager/5.2-1/0fcd7879

Wäre um jede Hilfe dankbar!

Damit ließe sich richtig was rausholen aus der Kiste.

Ich werde den Thread zukünftig auch mit weiteren Updates bestücken, immer wenn ich irgendwo voran komme.

Und natürlich mit weiteren Fragen, falls sich neue Probleme auftürmen; bin gespannt ob sich jemand für solch eine Spielerei interessiert. =)