Hallo liebe Community,

ich habe kürzlich ein Mainboard in einem meiner drei Knoten durch ein gleiches Modell ausgetauscht und installiert. Proxmox und das Cluster haben das auch sofort anerkannt und ihren Betrieb aufgenommen, Ceph hat ein Rebalancing der PGs gemacht und war danach wieder auf Grün.

Nach dem Update und dem Wiederanschluss des alten Knotens hatte ich das Problem, dass ich nach kurzer Zeit aus der Webconsole flog.

Dieses Problem konnte ich mit mit "touch /etc/pve/authkey.pub*" beheben.

Dann habe ich das Update auf die neue Version 9.1.1 gemacht weil ich die neue Containerunterstützung für OCI testen wollte.

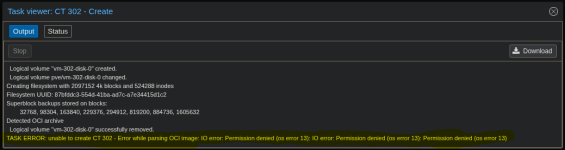

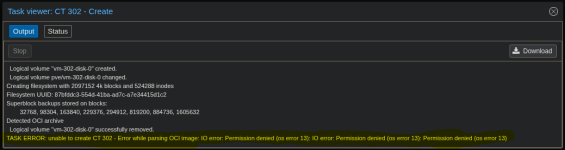

Dabei ist dann ein Fehler aufgetreten, wodurch die Erstellung des Containers fehlschlug

-> Fehlermeldung:

Der Fehler tritt sowohl bei der Erstellung auf dem local-LVM, wie auch auf dem Ceph-Pool auf.

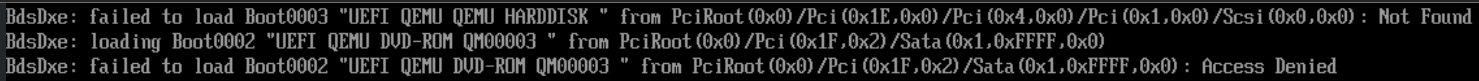

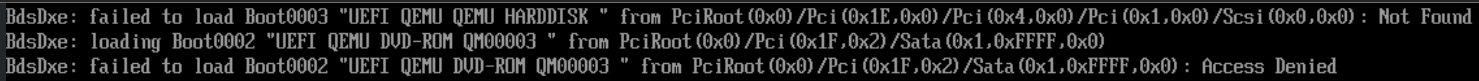

Ich habe dann versucht eine VM aufzusetzen, die ebenfalls einen Fehler beim booten macht.

Anbei ein Auszug:

Die VMs, die vor den Arbeiten bereits existierten, können jedoch problemlos neugestartet werden und funktionieren einwandfrei.

Die Anfragen an die KI schienen mir nur grob zielführend und ich habe mich auf die Ausgabe von Werten beschränkt.

Hier die Auszüge:

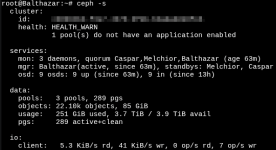

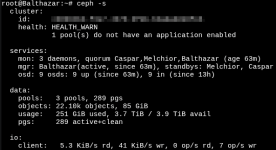

" ceph -s "

" ceph auth list " (die OSDs sehen alle ähnlich aus)

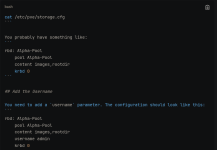

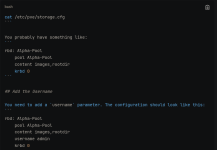

" cat /etc/pve/storage.cfg "

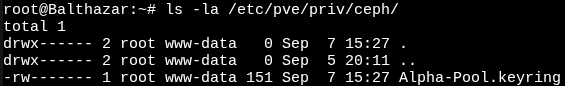

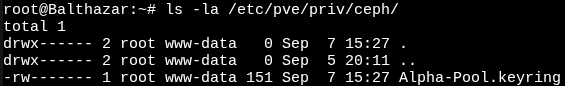

" ls -la /etc/pve/priv/ceph/ "

Die KI schlägt als nächstes vor, händisch einen Eintrag in der Datei "/etc/pve/storage.cfg" zu setzen, aber ich traue dem Braten nicht,

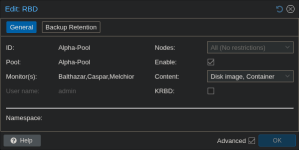

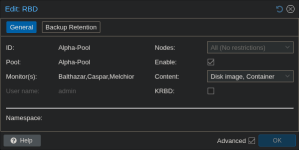

zumal ich diese Ausgabe aus dem Datacenter bekomme:

KI-Vorschlag:

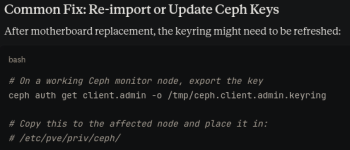

Die KI-hatte dann auch noch diesen Vorschlag, den ich zwar nachvollziehbar finde aber mir nicht sicher bin, ob das wirklich der richtige Weg sein soll:

Wie kann ich jetzt wieder Schreibrechte auf meinem eigenen Storage erlangen?

ich habe kürzlich ein Mainboard in einem meiner drei Knoten durch ein gleiches Modell ausgetauscht und installiert. Proxmox und das Cluster haben das auch sofort anerkannt und ihren Betrieb aufgenommen, Ceph hat ein Rebalancing der PGs gemacht und war danach wieder auf Grün.

Nach dem Update und dem Wiederanschluss des alten Knotens hatte ich das Problem, dass ich nach kurzer Zeit aus der Webconsole flog.

Dieses Problem konnte ich mit mit "touch /etc/pve/authkey.pub*" beheben.

Dann habe ich das Update auf die neue Version 9.1.1 gemacht weil ich die neue Containerunterstützung für OCI testen wollte.

Dabei ist dann ein Fehler aufgetreten, wodurch die Erstellung des Containers fehlschlug

-> Fehlermeldung:

Der Fehler tritt sowohl bei der Erstellung auf dem local-LVM, wie auch auf dem Ceph-Pool auf.

Ich habe dann versucht eine VM aufzusetzen, die ebenfalls einen Fehler beim booten macht.

Anbei ein Auszug:

Die VMs, die vor den Arbeiten bereits existierten, können jedoch problemlos neugestartet werden und funktionieren einwandfrei.

Die Anfragen an die KI schienen mir nur grob zielführend und ich habe mich auf die Ausgabe von Werten beschränkt.

Hier die Auszüge:

" ceph -s "

" ceph auth list " (die OSDs sehen alle ähnlich aus)

" cat /etc/pve/storage.cfg "

" ls -la /etc/pve/priv/ceph/ "

Die KI schlägt als nächstes vor, händisch einen Eintrag in der Datei "/etc/pve/storage.cfg" zu setzen, aber ich traue dem Braten nicht,

zumal ich diese Ausgabe aus dem Datacenter bekomme:

KI-Vorschlag:

Die KI-hatte dann auch noch diesen Vorschlag, den ich zwar nachvollziehbar finde aber mir nicht sicher bin, ob das wirklich der richtige Weg sein soll:

Wie kann ich jetzt wieder Schreibrechte auf meinem eigenen Storage erlangen?