Hallo,

hat mir jemand eine Idee:

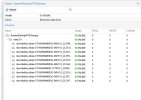

das auflisten meiner Backups funktioniert nicht.

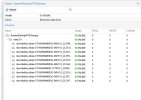

Auf PBS Gui Seite lädt beim klick auf den Namespace nichts.

auf PVE Seite als Storage eigebunden bekommen ich "Connection timed out (596)"

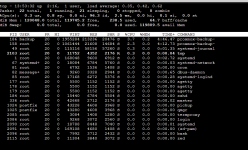

Im Terminal bekomme ich mit "/usr/sbin/pvesm list kaminocluter-pbs-01"

als Ergebnis

"error listing snapshots - 500 read timeout"

Der Storage ist ein ZRAID-2 dem es eigentlich gut geht:

Ein Speedtest auf dem Storage via Terminal sieht eigentlich auch in Ordnung aus:

Ich wäre für Ideen sehr Dankbar.

hat mir jemand eine Idee:

das auflisten meiner Backups funktioniert nicht.

Auf PBS Gui Seite lädt beim klick auf den Namespace nichts.

auf PVE Seite als Storage eigebunden bekommen ich "Connection timed out (596)"

Im Terminal bekomme ich mit "/usr/sbin/pvesm list kaminocluter-pbs-01"

als Ergebnis

"error listing snapshots - 500 read timeout"

Der Storage ist ein ZRAID-2 dem es eigentlich gut geht:

Ein Speedtest auf dem Storage via Terminal sieht eigentlich auch in Ordnung aus:

Code:

root@kaminocluter-pbs-01:/mnt/KaminoBackupPVEStorage# ./storage_speedtest.sh

Starting speed test in /mnt/KaminoBackupPVEStorage

Test file size: 1G

----------------------------------------

Testing write speed...

754 MB/s

Write test took 2 seconds

----------------------------------------

./storage_speedtest.sh: line 54: /proc/sys/vm/drop_caches: Read-only file system

Need sudo to clear cache

Testing read speed...

4.2 GB/s

Read test took 0 seconds

----------------------------------------

Testing IOPs...

random-write: (g=0): rw=randwrite, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=posixaio, iodepth=1

fio-3.33

Starting 1 process

Jobs: 1 (f=1): [w(1)][100.0%][w=4588KiB/s][w=1147 IOPS][eta 00m:00s]

random-write: (groupid=0, jobs=1): err= 0: pid=1552: Tue May 6 13:03:05 2025

write: IOPS=605, BW=2420KiB/s (2478kB/s)(23.8MiB/10076msec); 0 zone resets

slat (nsec): min=822, max=71224, avg=1239.86, stdev=1019.67

clat (usec): min=16, max=316503, avg=1646.28, stdev=8021.72

lat (usec): min=17, max=316504, avg=1647.52, stdev=8021.80

clat percentiles (usec):

| 1.00th=[ 19], 5.00th=[ 21], 10.00th=[ 169], 20.00th=[ 186],

| 30.00th=[ 196], 40.00th=[ 210], 50.00th=[ 229], 60.00th=[ 262],

| 70.00th=[ 289], 80.00th=[ 359], 90.00th=[ 5145], 95.00th=[ 9634],

| 99.00th=[ 19006], 99.50th=[ 22152], 99.90th=[ 42206], 99.95th=[225444],

| 99.99th=[316670]

bw ( KiB/s): min= 320, max= 4744, per=100.00%, avg=2438.00, stdev=1433.72, samples=20

iops : min= 80, max= 1186, avg=609.50, stdev=358.43, samples=20

lat (usec) : 20=4.31%, 50=4.53%, 250=47.95%, 500=26.89%, 750=1.64%

lat (usec) : 1000=0.69%

lat (msec) : 2=1.35%, 4=1.67%, 10=6.18%, 20=4.00%, 50=0.71%

lat (msec) : 100=0.02%, 250=0.02%, 500=0.05%

cpu : usr=0.29%, sys=0.17%, ctx=6099, majf=0, minf=23

IO depths : 1=100.0%, 2=0.0%, 4=0.0%, 8=0.0%, 16=0.0%, 32=0.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

issued rwts: total=0,6096,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=1

Run status group 0 (all jobs):

WRITE: bw=2420KiB/s (2478kB/s), 2420KiB/s-2420KiB/s (2478kB/s-2478kB/s), io=23.8MiB (25.0MB), run=10076-10076msec

Cleaning up...

----------------------------------------

Speed test completed!

Filesystem information:

Filesystem Size Used Avail Use% Mounted on

KaminoBackupPVEStorage/subvol-901-disk-0 110T 14T 96T 13% /mnt/KaminoBackupPVEStorageIch wäre für Ideen sehr Dankbar.