Guten Tag,

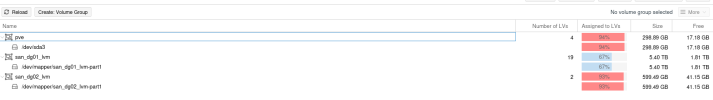

nach dem Update von PVE 7 zu 8 ist aufgefallen, dass bestimmter SAN Speicher nicht mehr zur Verfügung steht.

Zwei SAN Speicher sind über 2 mpaths (mpath0 und mpath1) konfiguriert. Nun stellte sich heraus, dass mpath0 weiterhin verbunden ist und läuft.

mpath1 hingegen lässt sich nur im debug einsehen. Sämtliche logs lassen nur darauf schließen, dass das Gerät busy ist.

Das Ganze passiert offensichtlich sobald der multipathd läuft, also ab boot.

Alle Versuche über lvm zu agieren scheitern schon daran, dass das physical volume nicht verfügbar ist.

Ich kann mir vorstellen, dass es eine Racecondition zwischen dem multipathd und lvm beim booten gibt. Momentan komme ich aber nicht wirklich weiter, da ich das System auch nicht munter hoch und runterfahren kann.

multipath -ll

multipath -d

journalctl -u multipathd

dmesg | grep -i "multipath"

lsblk

nach dem Update von PVE 7 zu 8 ist aufgefallen, dass bestimmter SAN Speicher nicht mehr zur Verfügung steht.

Zwei SAN Speicher sind über 2 mpaths (mpath0 und mpath1) konfiguriert. Nun stellte sich heraus, dass mpath0 weiterhin verbunden ist und läuft.

mpath1 hingegen lässt sich nur im debug einsehen. Sämtliche logs lassen nur darauf schließen, dass das Gerät busy ist.

Das Ganze passiert offensichtlich sobald der multipathd läuft, also ab boot.

Alle Versuche über lvm zu agieren scheitern schon daran, dass das physical volume nicht verfügbar ist.

Ich kann mir vorstellen, dass es eine Racecondition zwischen dem multipathd und lvm beim booten gibt. Momentan komme ich aber nicht wirklich weiter, da ich das System auch nicht munter hoch und runterfahren kann.

multipath -ll

Code:

mpath0 () dm-14

size=21T features='1 queue_if_no_path' hwhandler='1 alua' wp=rw

|-+- policy='round-robin 0' prio=50 status=active

| |- 11:0:0:0 sdc 8:32 active ready running

| `- 13:0:0:0 sdg 8:96 active ready running

`-+- policy='round-robin 0' prio=10 status=enabled

|- 12:0:0:0 sde 8:64 active ready running

`- 14:0:0:0 sdi 8:128 active ready runningmultipath -d

Code:

: mpath1 () undef

size=9.6T features='1 queue_if_no_path' hwhandler='1 alua' wp=undef

|-+- policy='round-robin 0' prio=50 status=undef

| |- 12:0:0:1 sdf 8:80 undef ready running

| `- 14:0:0:1 sdj 8:144 undef ready running

`-+- policy='round-robin 0' prio=10 status=undef

|- 11:0:0:1 sdd 8:48 undef ready running

`- 13:0:0:1 sdh 8:112 undef ready runningjournalctl -u multipathd

Code:

Feb 27 10:50:00 Proxmox systemd[1]: Starting Device-Mapper Multipath Device Controller...

Feb 27 10:50:00 Proxmox multipathd[1464]: --------start up--------

Feb 27 10:50:00 Proxmox multipathd[1464]: read /etc/multipath.conf

Feb 27 10:50:00 Proxmox multipathd[1464]: path checkers start up

Feb 27 10:50:00 Proxmox multipathd[1464]: failed to increase buffer size

Feb 27 10:50:00 Proxmox multipathd[1464]: mpath0: addmap [0 44711280640 multipath 1 queue_if_no_path 1 alua 2 1 round-robin 0 2 1 8:32 1 8:96 1 round-robin 0 2 1 8:64 1 8:128 1]

Feb 27 10:50:00 Proxmox multipathd[1464]: mpath1: addmap [0 20635975680 multipath 1 queue_if_no_path 1 alua 2 1 round-robin 0 2 1 8:80 1 8:144 1 round-robin 0 2 1 8:48 1 8:112 1]

Feb 27 10:50:00 Proxmox systemd[1]: Started Device-Mapper Multipath Device Controller.

Feb 27 11:10:56 Proxmox multipathd[1464]: mpath1: removing map by alias

Feb 27 11:10:57 Proxmox multipathd[1464]: dm-9: devmap not registered, can't remove

Feb 27 11:11:15 Proxmox multipathd[1464]: exit (signal)

Feb 27 11:11:15 Proxmox systemd[1]: Stopping Device-Mapper Multipath Device Controller...

Feb 27 11:11:16 Proxmox multipathd[1464]: --------shut down-------

Feb 27 11:11:16 Proxmox systemd[1]: multipathd.service: Succeeded.

Feb 27 11:11:16 Proxmox systemd[1]: Stopped Device-Mapper Multipath Device Controller.dmesg | grep -i "multipath"

Code:

[ 18.046720] systemd[1]: Listening on multipathd.socket - multipathd control socket.

[ 18.089390] systemd[1]: Starting multipathd.service - Device-Mapper Multipath Device Controller...

[ 18.834222] device-mapper: multipath round-robin: version 1.2.0 loaded

[ 18.873705] device-mapper: table: 252:15: multipath: error getting device (-EBUSY)

[ 18.879093] device-mapper: table: 252:15: multipath: error getting device (-EBUSY)

[ 18.880444] device-mapper: table: 252:15: multipath: error getting device (-EBUSY)

[ 18.881673] device-mapper: table: 252:15: multipath: error getting device (-EBUSY)lsblk

Code:

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 446.6G 0 disk

├─sda1 8:1 0 1007K 0 part

├─sda2 8:2 0 512M 0 part

└─sda3 8:3 0 444.5G 0 part

├─pve-swap 252:0 0 48G 0 lvm [SWAP]

├─pve-root 252:1 0 20G 0 lvm /

├─pve-data_tmeta 252:2 0 3.6G 0 lvm

└─pve-data_tdata 252:3 0 349.4G 0 lvm

sdb 8:16 0 7.3T 0 disk

└─sdb1 8:17 0 7.3T 0 part /mnt/pve/Server-RAID6

sdc 8:32 0 20.8T 0 disk

└─mpath0 252:14 0 20.8T 0 mpath

├─mpath0-part1 252:15 0 128M 0 part

└─mpath0-part2 252:16 0 20.8T 0 part

sdd 8:48 0 9.6T 0 disk

└─sdd1 8:49 0 9.6T 0 part

├─Storage--RAID6-vm--103--disk--0

│ 252:8 0 1.8T 0 lvm

├─Storage--RAID6-Storage_tmeta

│ 252:9 0 2G 0 lvm

│ └─Storage--RAID6-Storage-tpool

│ 252:11 0 7.8T 0 lvm

│ ├─Storage--RAID6-Storage

│ │ 252:12 0 7.8T 1 lvm

│ └─Storage--RAID6-vm--103--disk--1

│ 252:13 0 3.7T 0 lvm

└─Storage--RAID6-Storage_tdata

252:10 0 7.8T 0 lvm

└─Storage--RAID6-Storage-tpool

252:11 0 7.8T 0 lvm

├─Storage--RAID6-Storage

│ 252:12 0 7.8T 1 lvm

└─Storage--RAID6-vm--103--disk--1

252:13 0 3.7T 0 lvm

sde 8:64 0 20.8T 0 disk

└─mpath0 252:14 0 20.8T 0 mpath

├─mpath0-part1 252:15 0 128M 0 part

└─mpath0-part2 252:16 0 20.8T 0 part

sdf 8:80 0 9.6T 0 disk

└─sdf1 8:81 0 9.6T 0 part

sdg 8:96 0 20.8T 0 disk

└─mpath0 252:14 0 20.8T 0 mpath

├─mpath0-part1 252:15 0 128M 0 part

└─mpath0-part2 252:16 0 20.8T 0 part

sdh 8:112 0 9.6T 0 disk

└─sdh1 8:113 0 9.6T 0 part

sdi 8:128 0 20.8T 0 disk

└─mpath0 252:14 0 20.8T 0 mpath

├─mpath0-part1 252:15 0 128M 0 part

└─mpath0-part2 252:16 0 20.8T 0 part

sdj 8:144 0 9.6T 0 disk

└─sdj1 8:145 0 9.6T 0 partAttachments

Last edited: