Im Home- und Hobbybereich.

Mit

Werbung über die

Links.

Schreibe ich deshalb von diesem Mainboard:

*

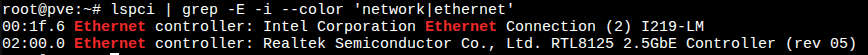

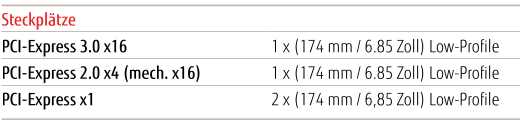

Biostar B760MX2-E Pro D4, 4x SATA3 (SSD), 4x SATA3 (HDD), 2x NVMe PCIe 4.0 x4, 1x 2.5 GBit/s NIC

#

https://www.biostar-europe.com/app/en/mb/export/spec_export.php?S_ID=1127

#

https://www.biostar-usa.com/app/en-us/mb/introduction.php?S_ID=1127

Rein für einen Proxmox Backup Server ist eine Intel LGA 1700 CPU 12100(T) ausreichend:

*

Intel® Core™ i3-12100

Für einen Proxmox VE Server könnte man auf diese Intel LGA 1700 CPU setze:

*

Intel® Core™ i5-13500

#

https://www.intel.de/content/www/de...-24m-cache-up-to-4-80-ghz/specifications.html

- Kerntyp 1 Performance, 6 Kerne, 12 Threads, Basistakt 2.500 MHz, Boost-Takt 4.800 MHz

- Kerntyp 2 Efficiency, 8 Kerne, 8 Threads, Basistakt 1.800 MHz, Boost-Takt 3.500 MHz

- Grafik GPU Intel® UHD Graphics 770

So erreicht man, dass das BS Proxmox VE genügend Kerne zur Verfügung hat und man kann das BS die P und E-Kerne auf die Prozesse verteilen lassen. Merke nur wenn ein LXC oder VM seine eigene CPU P- oder E-Kerne hat, kann er mit 100% Leistung abrufen.

Für einen Proxmox Backup Server würde ich DDR4 Ram mit 2x 16 GB, 32 GB wählen:

* G.Skill DIMM 32 GB DDR4-3200 (2x 16 GB) Dual-Kit Ripjaws V (F4-3200C16D-32GVK)

* G.Skill DIMM 32 GB DDR4-3200 (2x 16 GB) Dual-Kit Aegis (F4-3200C16D-32GIS)

* Kingston FURY DIMM 32 GB DDR4-3200 (2x 16 GB) Dual-Kit Beast (KF432C16BB1K2/32)

Als Speichermedien für ZFS gibt es sehr gut und bezahlbare SSDs:

* 2x

Kingston DC600M 480 GB

* 2x

Kingston DC600M 960 GB

#

https://www.kingston.com/de/ssd/dc600m-data-center-solid-state-drive

Hierauf installiert man, nach eigener Partitionierung,

a) den ZFS Pool rpool, 3 Partitionen als ZFS Mirror BIOS, EFI, 240 GB / 760 GB

b) dann die 4 Partition, 200 GB - 400 GB für der Pool dpool, als ZFS Mirror Special Device

Als Speichermedien für ZFS gibt es sehr gut und bezahlbare HDDs:

* 2x

Seagate IronWolf Pro NAS 2 TB CMR

* 2x

Seagate IronWolf Pro NAS 4 TB CMR

#

https://www.seagate.com/files/www-c.../ironwolf-pro-20tb-DS1914-21-2206US-en_US.pdf

Durch die insg. 8 x SATA 3 Schnittstellen, kann man im Bedarfsfall die 2x SSDs (ZFS Mirror), so wie auch 2x HDDs (ZFS Mirror) nachrüsten und einfach den unterschiedlichen ZFS Pool hinzufügen.

Man erhöht durch die Nutzung der SSDs als ZFS Special Device die gesamt IOPs des ZFS Pools massiv und z.B. ein

ls -lA #(dir) arbeitet "sofort".

Kingston DC600M 480/ 960 GB: IOPS Lesen 94.000 (Herstellerangabe)

Seagate IronWolf Pro NAS 4 TB CMR: IOPS Lesen ca. 125 (nach meinen Erfahrungen)

Man bedenke eine ZFS Mirror mit 2x Datenspeichern, hat eine ca. 2x hohe IOPS rand 4k read und 1x IOPS rand 4k write.

Nutz man später,

VDEV0 ZFS Mirror 2x HDD +

VDEV1 ZFS Mirror 2x HDD, als ZFS Stripe, so verdoppelt sich jeweils die IOPS im Lesen und Schreiben weiter! Und natürlich der nutzbare Datenspeicher.

So kann man einfach eine 2.5 GBit/s Schnittstelle mit ca. 250 MB/s auslasten.

Und denkt man an die beiden 2x NVMe PCIe 4.0 x4 auf dem Mainboard, so können diese, wenn man das passenden Klengeld hat, als ZFS Read-Cache für den ZFS Pool dpool verwendet werden.

ZFS sorgt selbst für die Verwaltung, es brauch nur noch ein paar GB Ram mehr; 1 GB ~ 1TB Speicher.

Als rundum ein skallierbares System im nicht gewerblichen Bereich.

Und klar: es kostet Geld und dass sind mir meine Daten und Programminstallationen wert!