Hallo again,

ich hab hier mal wieder was für euch in der Hoffnung mir kann geholfen werden.

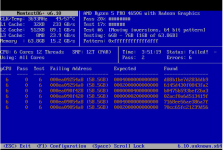

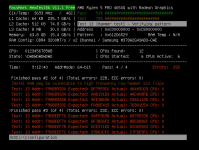

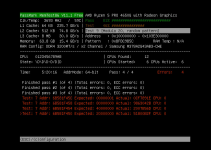

Diese Fehlermeldungen sind durchgehend bis jetzt, jede Sekunde ein neuer Eintrag, auch immer mit unterschiedlichen Core, socket Angaben.

Am Sonntag abend (als der Fehler zum ersten Mal auftrat) habe ich nicht wirklich bewusst etwas getan. Ich hatte am Sonntag angefangen von einer ntfs HDD Daten auf eine TrueNAS VM mit ZFS Raid zu kopieren. Die TrueNAS VM bekommt einen PCIe SAS Controller durchgereicht und lief bis dahin stabil.

Heute morgen konnte ich mich nicht mehr per Konsole auf die TrueNAS VM connecten, per ssh ging auch nichts aber auf die WebUI von TrueNAS selbst schon.

Das Dashborad dort zeigte keine Fehler an und auch die Logs waren okay.

Ich habe dann von dort aus die VM heruntergefahren und wollte zum testen ein Backup der TrueNAS VM zurückspielen.

Beim Klick auf "zurückspielen" kommt dann ( jedem Backup der TrueNAS VM)

Dann wollte ich wegen dem Backup Fehler einer Anleitung aus dem Forum folgen die erstmal ein Update vorraussetzt. Wenn ich über die GUI ein Update starten will:

Wenn ich über die Shell ein apt update machen will

Während ich angenfangen habe den Post zu schreiben, wollte ich noch die anderen VM herunterfahren um proxmox mal neu zu starten, inzwischen geht über die proxmox GUI immer weniger und auch die Shell reagiert nicht mehr.

ich hab hier mal wieder was für euch in der Hoffnung mir kann geholfen werden.

Code:

Jan 19 20:33:42 HomeLab kernel: qm[258790]: segfault at 7987cf401f92 ip 00007985d7e79305 sp 00007ffce8b480d0 error 4 in ld-linux-x86-64.so.2[7985d7e6c000+25000] likely on CPU 0 (core 0, socket 0)

Jan 19 20:33:42 HomeLab kernel: Code: 08 48 8b 85 60 ff ff ff 48 8b bd 78 ff ff ff 48 8b b5 58 ff ff ff 4c 89 f2 48 03 33 45 89 f5 48 c1 ea 20 48 89 b5 70 ff ff ff <0f> b7 04 50 48 8d 14 52 4c 8d 24 d7 25 ff 7f 00 00 4c 89 65 80 48

Jan 19 20:33:44 HomeLab kernel: qm[258796]: segfault at 73e59a801f92 ip 000073e3a3285305 sp 00007ffffc4801e0 error 4 in ld-linux-x86-64.so.2[73e3a3278000+25000] likely on CPU 2 (core 2, socket 0)

Jan 19 20:33:44 HomeLab kernel: Code: 08 48 8b 85 60 ff ff ff 48 8b bd 78 ff ff ff 48 8b b5 58 ff ff ff 4c 89 f2 48 03 33 45 89 f5 48 c1 ea 20 48 89 b5 70 ff ff ff <0f> b7 04 50 48 8d 14 52 4c 8d 24 d7 25 ff 7f 00 00 4c 89 65 80 48

Jan 19 20:33:46 HomeLab kernel: qm[258805]: segfault at 7e9921201f92 ip 00007e9729df4305 sp 00007ffdcda265c0 error 4 in ld-linux-x86-64.so.2[7e9729de7000+25000] likely on CPU 2 (core 2, socket 0)

Jan 19 20:33:46 HomeLab kernel: Code: 08 48 8b 85 60 ff ff ff 48 8b bd 78 ff ff ff 48 8b b5 58 ff ff ff 4c 89 f2 48 03 33 45 89 f5 48 c1 ea 20 48 89 b5 70 ff ff ff <0f> b7 04 50 48 8d 14 52 4c 8d 24 d7 25 ff 7f 00 00 4c 89 65 80 48

Jan 19 20:33:48 HomeLab kernel: qm[258811]: segfault at 7c888e801f92 ip 00007c86972a1305 sp 00007ffdf95d5860 error 4 in ld-linux-x86-64.so.2[7c8697294000+25000] likely on CPU 2 (core 2, socket 0)Diese Fehlermeldungen sind durchgehend bis jetzt, jede Sekunde ein neuer Eintrag, auch immer mit unterschiedlichen Core, socket Angaben.

Am Sonntag abend (als der Fehler zum ersten Mal auftrat) habe ich nicht wirklich bewusst etwas getan. Ich hatte am Sonntag angefangen von einer ntfs HDD Daten auf eine TrueNAS VM mit ZFS Raid zu kopieren. Die TrueNAS VM bekommt einen PCIe SAS Controller durchgereicht und lief bis dahin stabil.

Heute morgen konnte ich mich nicht mehr per Konsole auf die TrueNAS VM connecten, per ssh ging auch nichts aber auf die WebUI von TrueNAS selbst schon.

Das Dashborad dort zeigte keine Fehler an und auch die Logs waren okay.

Ich habe dann von dort aus die VM heruntergefahren und wollte zum testen ein Backup der TrueNAS VM zurückspielen.

Beim Klick auf "zurückspielen" kommt dann ( jedem Backup der TrueNAS VM)

Code:

Failed to extract config from VMA archive: /bin/bash: line 1: 1511436 Exit 70 zstd -q -d -c /mnt/lvmdir/dump/vzdump-qemu-103-2025_01_22-02_00_05.vma.zst (500)Dann wollte ich wegen dem Backup Fehler einer Anleitung aus dem Forum folgen die erstmal ein Update vorraussetzt. Wenn ich über die GUI ein Update starten will:

Code:

()

starting apt-get update

TASK ERROR: command 'apt-get update' failed: got signal 11Wenn ich über die Shell ein apt update machen will

Code:

Segment faultWährend ich angenfangen habe den Post zu schreiben, wollte ich noch die anderen VM herunterfahren um proxmox mal neu zu starten, inzwischen geht über die proxmox GUI immer weniger und auch die Shell reagiert nicht mehr.