Wir haben seit einem knappen Monat einen Proxmox Server (v 9.1.1) zum Testen am laufen.

aktuell läuft darauf nur eine VM und die lief bisher auch problemlos. Nun wollte ich heute einen Snapshot erstellen, das schlug fehl. Bei einem Neustart der VM, konnte diese nicht mehr neu gestartet werden.

Ich versuche mal alles hier rein zu packen, von dem ich denke, dass es helfen kann, um mein Problem zu finden.

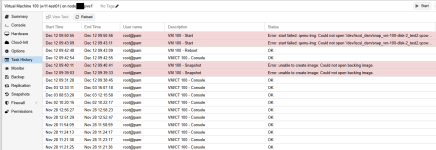

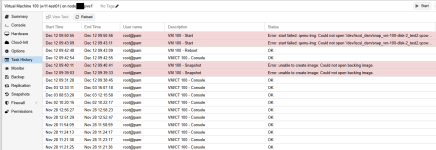

Task History der VM:

letzte Zeilen vom Snapshot Task Log:

Log vom VM Start Task:

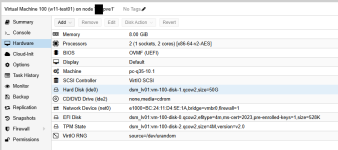

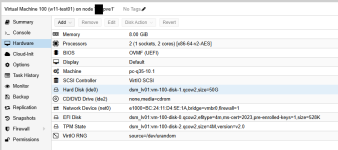

VM Konfig/Hardware:

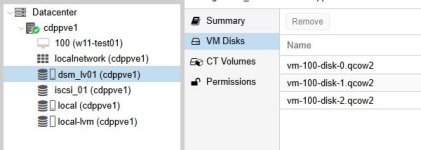

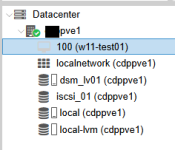

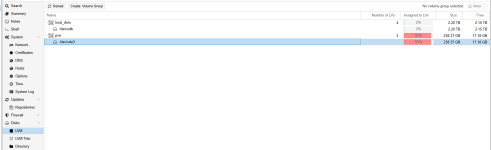

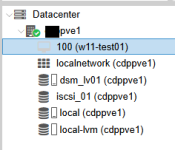

Übersicht PVE:

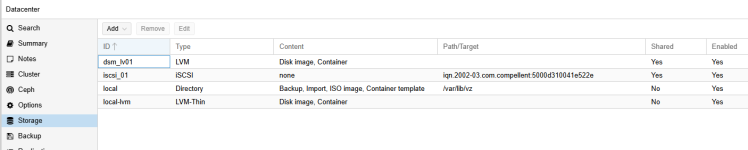

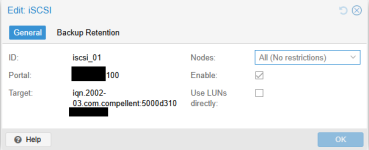

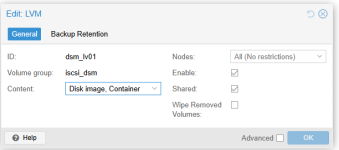

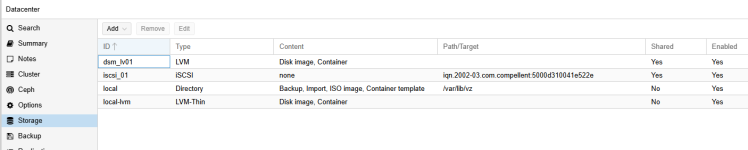

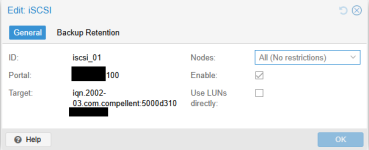

Storage Config (datacenter/iSCSI):

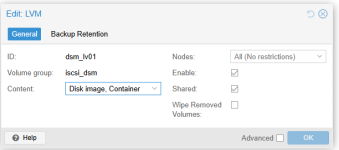

Storage PVE Knoten:

Bin im Thema Proxmox relativ neu und mir fehlt hier der Ansatz, warum a) kein Snapshot gemacht werden konnte und b) die Maschine jetzt die disk nicht mehr finden und starten mag.

Haben sowohl die VM als auch den PVE Knoten inzwischen mal neu gestartet.

aktuell läuft darauf nur eine VM und die lief bisher auch problemlos. Nun wollte ich heute einen Snapshot erstellen, das schlug fehl. Bei einem Neustart der VM, konnte diese nicht mehr neu gestartet werden.

Ich versuche mal alles hier rein zu packen, von dem ich denke, dass es helfen kann, um mein Problem zu finden.

Task History der VM:

letzte Zeilen vom Snapshot Task Log:

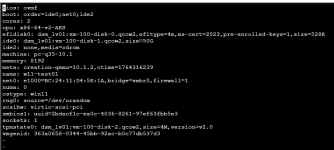

Code:

commit-drive-efidisk0: Completing block job...

commit-drive-efidisk0: Completed successfully.

commit-drive-efidisk0: commit-job finished

delete old /dev/iscsi_dsm/vm-100-disk-0.qcow2

Logical volume "vm-100-disk-0.qcow2" successfully removed.

Renamed "snap_vm-100-disk-0_O2024.qcow2" to "vm-100-disk-0.qcow2" in volume group "iscsi_dsm"

blockdev replace O2024 by current

TASK ERROR: unable to create image: Could not open backing image.Log vom VM Start Task:

Code:

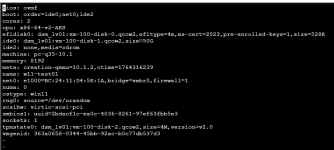

TASK ERROR: start failed: qemu-img: Could not open '/dev/iscsi_dsm/snap_vm-100-disk-2_test2.qcow2': Could not open '/dev/iscsi_dsm/snap_vm-100-disk-2_test2.qcow2': No such file or directoryVM Konfig/Hardware:

Übersicht PVE:

Storage Config (datacenter/iSCSI):

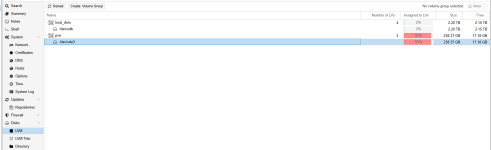

Storage PVE Knoten:

Bin im Thema Proxmox relativ neu und mir fehlt hier der Ansatz, warum a) kein Snapshot gemacht werden konnte und b) die Maschine jetzt die disk nicht mehr finden und starten mag.

Haben sowohl die VM als auch den PVE Knoten inzwischen mal neu gestartet.