Hallo und frohes Neues 2026. Alles Gute für Euch und das ganze Team!

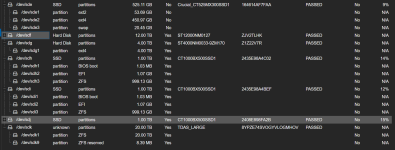

Ich hab nicht gehört und nun bekomme ich die Rechnung. Mein Proxmox system Läuft auf einem ZFS von ca 3TB aus 3 jeweils 1TB großen Consumer SSDs.

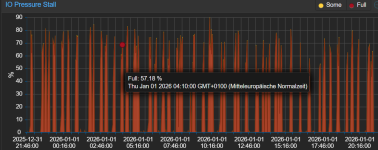

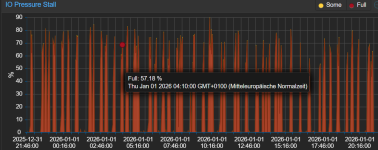

Nun passiert es regelmäßig, dass das ganze System "zögert" also langsam bis gar nicht reagiert, wenn auf dem System-ZFS etwas passiert. Beispiele sind z.B. Home Assistant, der vor dem Update ein Backup macht oder seine Daten aufräumt beim löschen, Ändern oder Hinzufügen von Sensoren.

Wie komme ich aus dem Schlamassel elegant raus, ohne gleich auf 3 Server-SSDs umzurüsten? Ich habe z.B. noch einen Slot im SSD_Tray frei und könnte eine super schnelle aber kleine SSD hinzufügen als Cache. Oder ich könnte eine PCIe-8x Karte hinzustecken mit Steckplätzen für NVMEs. Aber aktuell habe ich noch andere Prioritäten und suche daher einen zuverlässigen kostengünstigen Weg, den Consumer SSDs die Last zu reduzieren und das ganze System flüssiger zu bekommen.

Für ein paar einfache Schritte und ggf. nötige Kaufempfehlungen wäre ich sehr dankbar!

Alles Gute und vielen Dank

Astralix

Ich hab nicht gehört und nun bekomme ich die Rechnung. Mein Proxmox system Läuft auf einem ZFS von ca 3TB aus 3 jeweils 1TB großen Consumer SSDs.

Nun passiert es regelmäßig, dass das ganze System "zögert" also langsam bis gar nicht reagiert, wenn auf dem System-ZFS etwas passiert. Beispiele sind z.B. Home Assistant, der vor dem Update ein Backup macht oder seine Daten aufräumt beim löschen, Ändern oder Hinzufügen von Sensoren.

Wie komme ich aus dem Schlamassel elegant raus, ohne gleich auf 3 Server-SSDs umzurüsten? Ich habe z.B. noch einen Slot im SSD_Tray frei und könnte eine super schnelle aber kleine SSD hinzufügen als Cache. Oder ich könnte eine PCIe-8x Karte hinzustecken mit Steckplätzen für NVMEs. Aber aktuell habe ich noch andere Prioritäten und suche daher einen zuverlässigen kostengünstigen Weg, den Consumer SSDs die Last zu reduzieren und das ganze System flüssiger zu bekommen.

Für ein paar einfache Schritte und ggf. nötige Kaufempfehlungen wäre ich sehr dankbar!

Alles Gute und vielen Dank

Astralix