Hi

ich wollte mal fragen ob das jemand bestätigen kann.

Setup:

HW: Xeon X3440, 1TB SSD SATA, 16 GB MEM

SW: Proxmox VE 7, ZFS , alles nur auf der lokalen Disk installiert. Keine speziellen Optionen ausgewählt.

VM: Windows 10 21H1, 4GB MEM, 64GB HD, letzte Patche und ATTO Disk Benchmark, Virtio disc und Netz, kein Balloon treiber. (Mit Balloon TReiber gibt es den gleichen Effekt)

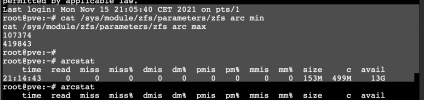

Einfach mal den Diskbenchmark laufen lassen (Bild1) und dann beginnt mit einem mal der Kernel die Prozesse zu killen und die Kiste steht dann (Bild2).

Gleiches setup aber ext4 als FS bei der installation gewählt. Alles geht.

ich wollte mal fragen ob das jemand bestätigen kann.

Setup:

HW: Xeon X3440, 1TB SSD SATA, 16 GB MEM

SW: Proxmox VE 7, ZFS , alles nur auf der lokalen Disk installiert. Keine speziellen Optionen ausgewählt.

VM: Windows 10 21H1, 4GB MEM, 64GB HD, letzte Patche und ATTO Disk Benchmark, Virtio disc und Netz, kein Balloon treiber. (Mit Balloon TReiber gibt es den gleichen Effekt)

Einfach mal den Diskbenchmark laufen lassen (Bild1) und dann beginnt mit einem mal der Kernel die Prozesse zu killen und die Kiste steht dann (Bild2).

Gleiches setup aber ext4 als FS bei der installation gewählt. Alles geht.