Hi,

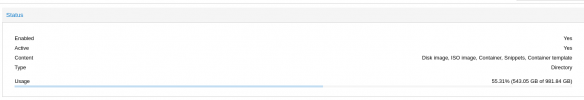

warum wird mir in der Proxmox GUI angezeigt, dass beide Festplatten gleich belegt sind.

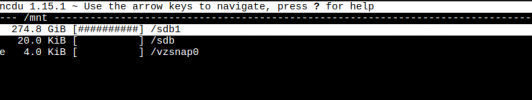

Wenn ich direkt auf dem Server schaue, stimmen die Werte jedoch nicht überein.

warum wird mir in der Proxmox GUI angezeigt, dass beide Festplatten gleich belegt sind.

Wenn ich direkt auf dem Server schaue, stimmen die Werte jedoch nicht überein.