Hallo zusammen!

Ich habe von einiger Zeit mein ProxmoxVE gemirrort auf HDDs (aka. "Blech") mit je 838.36 GiB installiert.

Nun würde ich gerne - um das Setup ein wenig zu "entzerren" und ProxmoxVE auf meinem doch betagten RX300 S8 schneller zu booten - die eigentliche ProxmoxVE-Installation auf SSDs umziehen wollen (jeweils 186.31 GiB).

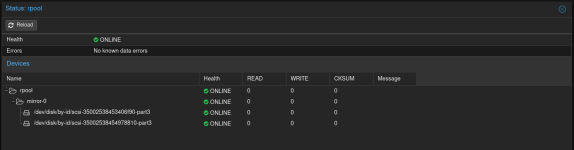

Mein Setup sieht also Plattentechnisch gerade so aus:

Output von 'lsblk':

(/dev/sda und /dev/sdb sind die momentan gemirrorten HDDs, /dev/sdc und /dev/sdd die SSDs die es werden sollen)

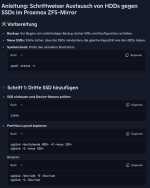

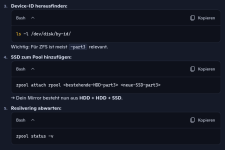

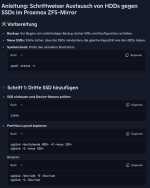

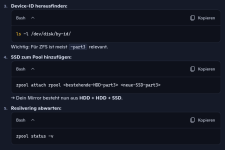

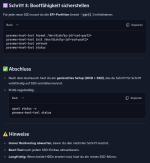

Ich hab mir von Copilot eine Anleitung zusammenschreiben lassen, wie ich Platten (HDDs) Schritt für Schritt durch die SSDs ersetzen kann:

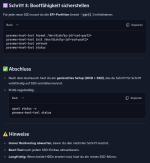

Jetzt kommt allerdings mein Problem!

Wenn ich mit dem Punkt 'Partitions Layout kopieren' anfange, bekomme ich die folgende Meldung:

Es scheint wohl leider keine gute Idee zu sein, den Inhalt meiner größeren HDDs auf die kleinen SSDs kopieren zu wollen ....

....

Gibt es trotzdem Möglichkeiten, die Migration durchzuführen, ohne mein ProxmoxVE auf den SSDs komplett neu aufsetzen zu müssen?

Ich danke euch für eure Tipps

Ich habe von einiger Zeit mein ProxmoxVE gemirrort auf HDDs (aka. "Blech") mit je 838.36 GiB installiert.

Nun würde ich gerne - um das Setup ein wenig zu "entzerren" und ProxmoxVE auf meinem doch betagten RX300 S8 schneller zu booten - die eigentliche ProxmoxVE-Installation auf SSDs umziehen wollen (jeweils 186.31 GiB).

Mein Setup sieht also Plattentechnisch gerade so aus:

Output von 'lsblk':

Code:

root@pve:~# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 838.4G 0 disk

├─sda1 8:1 0 1007K 0 part

├─sda2 8:2 0 1G 0 part

└─sda3 8:3 0 837.4G 0 part

sdb 8:16 0 838.4G 0 disk

├─sdb1 8:17 0 1007K 0 part

├─sdb2 8:18 0 1G 0 part

└─sdb3 8:19 0 837.4G 0 part

sdc 8:32 0 186.3G 0 disk

sdd 8:48 0 186.3G 0 disk(/dev/sda und /dev/sdb sind die momentan gemirrorten HDDs, /dev/sdc und /dev/sdd die SSDs die es werden sollen)

Ich hab mir von Copilot eine Anleitung zusammenschreiben lassen, wie ich Platten (HDDs) Schritt für Schritt durch die SSDs ersetzen kann:

Jetzt kommt allerdings mein Problem!

Wenn ich mit dem Punkt 'Partitions Layout kopieren' anfange, bekomme ich die folgende Meldung:

Code:

root@pve:~# sgdisk /dev/sda -R /dev/sdc

Caution! Secondary header was placed beyond the disk's limits! Moving the

header, but other problems may occur!

Warning! Secondary partition table overlaps the last partition by

1367452800 blocks!

You will need to delete this partition or resize it in another utility.

Problem: partition 3 is too big for the disk.

Aborting write operation!

Aborting write of new partition table.

root@pve:~#Es scheint wohl leider keine gute Idee zu sein, den Inhalt meiner größeren HDDs auf die kleinen SSDs kopieren zu wollen

Gibt es trotzdem Möglichkeiten, die Migration durchzuführen, ohne mein ProxmoxVE auf den SSDs komplett neu aufsetzen zu müssen?

Ich danke euch für eure Tipps