Hallo zusammen,

habe eine neue Festplatte installiert und wollte nun im NUC alles umziehen. Die VM 320 habe ich über Hardware Laufwerk erfolgreich umgezogen siehe Bild.

Nun erhalte ich im Log ein fehler. pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Hoffe ihr könnt mir Helfen.

Wollte auch den pve dann löschen und pve1 als knoten haben. Hier ist auch ein Localnetwork.

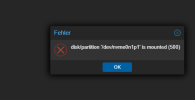

Beim Zurück verschieben habe ich auch einen Fehler:

ec 17 14:14:23 pve pveproxy[402964]: worker exit

Dec 17 14:14:23 pve pveproxy[1292]: worker 402964 finished

Dec 17 14:14:23 pve pveproxy[1292]: starting 1 worker(s)

Dec 17 14:14:23 pve pveproxy[1292]: worker 407600 started

Dec 17 14:14:26 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:27 pve pvedaemon[406379]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:27 pve pvedaemon[399527]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:28 pve pvedaemon[407449]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:37 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:46 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:56 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:58 pve pvedaemon[406379]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:59 pve pvedaemon[407449]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:59 pve pvedaemon[399527]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:15:06 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

habe eine neue Festplatte installiert und wollte nun im NUC alles umziehen. Die VM 320 habe ich über Hardware Laufwerk erfolgreich umgezogen siehe Bild.

Nun erhalte ich im Log ein fehler. pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Hoffe ihr könnt mir Helfen.

Wollte auch den pve dann löschen und pve1 als knoten haben. Hier ist auch ein Localnetwork.

Beim Zurück verschieben habe ich auch einen Fehler:

ec 17 14:14:23 pve pveproxy[402964]: worker exit

Dec 17 14:14:23 pve pveproxy[1292]: worker 402964 finished

Dec 17 14:14:23 pve pveproxy[1292]: starting 1 worker(s)

Dec 17 14:14:23 pve pveproxy[1292]: worker 407600 started

Dec 17 14:14:26 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:27 pve pvedaemon[406379]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:27 pve pvedaemon[399527]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:28 pve pvedaemon[407449]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:37 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:46 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:56 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:58 pve pvedaemon[406379]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:59 pve pvedaemon[407449]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:14:59 pve pvedaemon[399527]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Dec 17 14:15:06 pve pvestatd[1270]: command '/sbin/vgscan --ignorelockingfailure --mknodes' failed: exit code 5

Last edited: