Hallo zusammen,

wir betreiben ein Proxmox-Cluster mit Ceph-Storage.

Trotz der Verwendung von NVMe-Speichern, mit denen alle anderen Anwendungen sehr zufrieden sind, berichtet die ETCD-Datenbank unseres Kubernetes-Clusters über eine zu hohe Latenz beim Schreiben.

Nach meinem Verständnis ist die ETCD-Datenbank so konzipiert, dass sie eine Schreibbestätigung erst nach dem tatsächlichen Schreiben auf die Festplatte sendet. Designbedingt darf kein Cache verwendet werden...

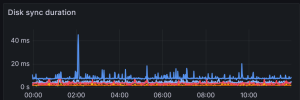

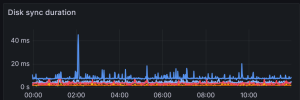

Ich muss eine Latenz von unter 10ms halten, um Probleme zu vermeiden. Die blaue Linee repräsentiert die ETCD auf dem Proxmox-Cluster mit Ceph. Die anderen beiden Linieen gehören zu unserem alten Cluster.

Hier sieht man, dass der blaue Balken gerne nach oben ausschlägt... und leider auch bis zu 200ms erreicht, wenn auf anderen viruelle Maschinen intensive I/O-Operationen stattfinden. Eine Lösung könnte sein, in diesem Cluster speziell sehr schnelle, kleine NVMe-Speicher ausschließlich für die ETCD zu verwenden. Meine Frage: Was wäre die beste Lösung für die Anbindung diese Kleine Platten an Proxmox? Welche Art von Storage sollte ich am besten verwenden?

Vielen Dank

wir betreiben ein Proxmox-Cluster mit Ceph-Storage.

Trotz der Verwendung von NVMe-Speichern, mit denen alle anderen Anwendungen sehr zufrieden sind, berichtet die ETCD-Datenbank unseres Kubernetes-Clusters über eine zu hohe Latenz beim Schreiben.

Nach meinem Verständnis ist die ETCD-Datenbank so konzipiert, dass sie eine Schreibbestätigung erst nach dem tatsächlichen Schreiben auf die Festplatte sendet. Designbedingt darf kein Cache verwendet werden...

Ich muss eine Latenz von unter 10ms halten, um Probleme zu vermeiden. Die blaue Linee repräsentiert die ETCD auf dem Proxmox-Cluster mit Ceph. Die anderen beiden Linieen gehören zu unserem alten Cluster.

Hier sieht man, dass der blaue Balken gerne nach oben ausschlägt... und leider auch bis zu 200ms erreicht, wenn auf anderen viruelle Maschinen intensive I/O-Operationen stattfinden. Eine Lösung könnte sein, in diesem Cluster speziell sehr schnelle, kleine NVMe-Speicher ausschließlich für die ETCD zu verwenden. Meine Frage: Was wäre die beste Lösung für die Anbindung diese Kleine Platten an Proxmox? Welche Art von Storage sollte ich am besten verwenden?

Vielen Dank