Ich Augenblick bist Du im Prozess des reparieren des ZFS Pools und dabei sind mir Probleme aufgefallen, die vor Nutzung korrigieren möchte.

Wenn dann die mitlesenden Administratoren Dir alles wichtige mitgeteilt haben, dann geht es mit

# https://forum.proxmox.com/threads/einbinden-einer-vorhandenen-festplatte-ohne-die-verzeichnissse-und-dateien-zu-löschen.162348/post-748705

weiter.

Vorher muss die Kontrolle über den ZFS Pool natürlich von Proxmox genommen werden.

Ob das Vorgehen das einzigste und sinnvollste ist, ist nicht bekannt, da deine die Zielsetzung und die Daten unbekannt sind.

Ich nutze Samba (CIFS) für die Bereitstellung von Daten an VM über einen privileged LXC, in dem ein Samba Server läuft. Dem LXC übergebe ich ein ZFS Dataset als Bind-Mountpoint.

# https://pve.proxmox.com/wiki/Linux_Container

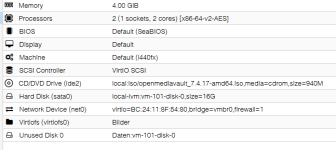

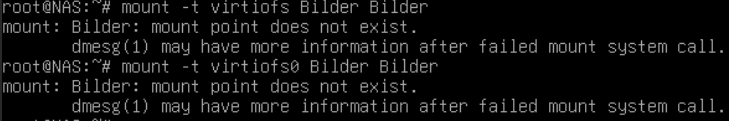

Mit Proxmox 8.4.1 ist nun funktionierend und über die GUI administrierbar Virtiofs eingezogen.

# https://pve.proxmox.com/wiki/QEMU/KVM_Virtual_Machines

Wenn dann die mitlesenden Administratoren Dir alles wichtige mitgeteilt haben, dann geht es mit

# https://forum.proxmox.com/threads/einbinden-einer-vorhandenen-festplatte-ohne-die-verzeichnissse-und-dateien-zu-löschen.162348/post-748705

weiter.

Vorher muss die Kontrolle über den ZFS Pool natürlich von Proxmox genommen werden.

zpool export <pool-name>Ob das Vorgehen das einzigste und sinnvollste ist, ist nicht bekannt, da deine die Zielsetzung und die Daten unbekannt sind.

Ich nutze Samba (CIFS) für die Bereitstellung von Daten an VM über einen privileged LXC, in dem ein Samba Server läuft. Dem LXC übergebe ich ein ZFS Dataset als Bind-Mountpoint.

# https://pve.proxmox.com/wiki/Linux_Container

Mit Proxmox 8.4.1 ist nun funktionierend und über die GUI administrierbar Virtiofs eingezogen.

# https://pve.proxmox.com/wiki/QEMU/KVM_Virtual_Machines

Last edited: