Hallo, ich brächte bitte Eure Hilfe.

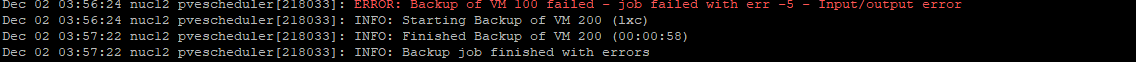

Seit Wochen habe ich immer wieder Probleme mit einem Backup einer VM.

Diese wird aufs NAS gespeichert.

Die NAS kann ich als Problem ausschliessen.

Das Backup wird mit einem I/O Error beendet.

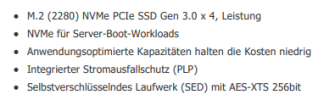

Die betroffene NVMe hat PLP, ist also keine billige.

Das System läuft auf einem ZFS Raid 1 mit der besagten NVMe und einer 2.5 SSD ebenso mit PLP.

zpool status liefert keine Unregelmässigkeiten.

Smartctl -a liefert bei der NVMe eine hohe Anzahl von Error Counts.

Hier die Ausgabe#

Die 2.5 Zoll SSD hat folgende Ausgabe.

Kann man sagen das die NVMe das Problem verursacht?

Bzw. was kann ich noch tun um den Fehler zu finden?

Die NVMe hat gerade einmal einen wareout von 1%.

Das Backup funktioniert mittlerweile gar nicht mehr, hab den Zeitplan jetzt deaktviert.

Das System läuft aber an sich stabil.

Danke schon mal....

Seit Wochen habe ich immer wieder Probleme mit einem Backup einer VM.

Diese wird aufs NAS gespeichert.

Die NAS kann ich als Problem ausschliessen.

Das Backup wird mit einem I/O Error beendet.

Die betroffene NVMe hat PLP, ist also keine billige.

Das System läuft auf einem ZFS Raid 1 mit der besagten NVMe und einer 2.5 SSD ebenso mit PLP.

zpool status liefert keine Unregelmässigkeiten.

Smartctl -a liefert bei der NVMe eine hohe Anzahl von Error Counts.

Hier die Ausgabe#

Code:

root@nuc12:~# smartctl -a /dev/nvme0n1

smartctl 7.3 2022-02-28 r5338 [x86_64-linux-6.8.12-4-pve] (local build)

Copyright (C) 2002-22, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Model Number: KINGSTON SEDC1000BM8480G

Serial Number: 50026B7686AB2C5A

Firmware Version: ECEK22.3

PCI Vendor/Subsystem ID: 0x2646

IEEE OUI Identifier: 0x0026b7

Total NVM Capacity: 480,103,981,056 [480 GB]

Unallocated NVM Capacity: 0

Controller ID: 1

NVMe Version: 1.3

Number of Namespaces: 1

Namespace 1 Size/Capacity: 480,103,981,056 [480 GB]

Namespace 1 Formatted LBA Size: 512

Namespace 1 IEEE EUI-64: 0026b7 686ab2c5a0

Local Time is: Mon Dec 2 13:03:02 2024 CET

Firmware Updates (0x12): 1 Slot, no Reset required

Optional Admin Commands (0x001f): Security Format Frmw_DL NS_Mngmt Self_Test

Optional NVM Commands (0x0054): DS_Mngmt Sav/Sel_Feat Timestmp

Log Page Attributes (0x0a): Cmd_Eff_Lg Telmtry_Lg

Maximum Data Transfer Size: 512 Pages

Warning Comp. Temp. Threshold: 75 Celsius

Critical Comp. Temp. Threshold: 80 Celsius

Supported Power States

St Op Max Active Idle RL RT WL WT Ent_Lat Ex_Lat

0 + 8.92W - - 0 0 0 0 0 0

Supported LBA Sizes (NSID 0x1)

Id Fmt Data Metadt Rel_Perf

0 + 512 0 2

1 - 4096 0 1

=== START OF SMART DATA SECTION ===

SMART overall-health self-assessment test result: PASSED

SMART/Health Information (NVMe Log 0x02)

Critical Warning: 0x00

Temperature: 43 Celsius

Available Spare: 100%

Available Spare Threshold: 10%

Percentage Used: 1%

Data Units Read: 16,930,568 [8.66 TB]

Data Units Written: 20,758,029 [10.6 TB]

Host Read Commands: 210,446,916

Host Write Commands: 452,938,554

Controller Busy Time: 529

Power Cycles: 8

Power On Hours: 7,052

Unsafe Shutdowns: 2

Media and Data Integrity Errors: 0

Error Information Log Entries: 52

Warning Comp. Temperature Time: 0

Critical Comp. Temperature Time: 0

Error Information (NVMe Log 0x01, 16 of 63 entries)

Num ErrCount SQId CmdId Status PELoc LBA NSID VS

0 52 0 0x0010 0x4004 0x028 0 0 -

1 51 0 0x000f 0x4004 - 0 0 -

root@nuc12:~#Die 2.5 Zoll SSD hat folgende Ausgabe.

Code:

root@nuc12:~# smartctl -a /dev/sda

smartctl 7.3 2022-02-28 r5338 [x86_64-linux-6.8.12-4-pve] (local build)

Copyright (C) 2002-22, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Device Model: KINGSTON SEDC600M480G

Serial Number: 50026B768698A5B5

LU WWN Device Id: 5 0026b7 68698a5b5

Firmware Version: SCEKH5.1

User Capacity: 480,103,981,056 bytes [480 GB]

Sector Size: 512 bytes logical/physical

Rotation Rate: Solid State Device

Form Factor: 2.5 inches

TRIM Command: Available, deterministic, zeroed

Device is: Not in smartctl database 7.3/5319

ATA Version is: ACS-3 (minor revision not indicated)

SATA Version is: SATA 3.1, 6.0 Gb/s (current: 6.0 Gb/s)

Local Time is: Mon Dec 2 13:04:59 2024 CET

SMART support is: Available - device has SMART capability.

SMART support is: Enabled

=== START OF READ SMART DATA SECTION ===

SMART overall-health self-assessment test result: PASSED

General SMART Values:

Offline data collection status: (0x00) Offline data collection activity

was never started.

Auto Offline Data Collection: Disabled.

Self-test execution status: ( 0) The previous self-test routine completed without error or no self-test has ever

been run.

Total time to complete Offline

data collection: ( 30) seconds.

Offline data collection

capabilities: (0x79) SMART execute Offline immediate.

No Auto Offline data collection support. Suspend Offline collection upon new

command.

Offline surface scan supported.

Self-test supported.

Conveyance Self-test supported.

Selective Self-test supported.

SMART capabilities: (0x0003) Saves SMART data before entering

power-saving mode.

Supports SMART auto save timer.

Error logging capability: (0x01) Error logging supported.

General Purpose Logging supported.

Short self-test routine

recommended polling time: ( 1) minutes.

Extended self-test routine

recommended polling time: ( 2) minutes.

Conveyance self-test routine

recommended polling time: ( 3) minutes.

SMART Attributes Data Structure revision number: 16

Vendor Specific SMART Attributes with Thresholds:

ID# ATTRIBUTE_NAME FLAG VALUE WORST THRESH TYPE UPDATED WHEN_FAILED RAW_VALUE

1 Raw_Read_Error_Rate 0x0032 100 100 000 Old_age Always - 0

9 Power_On_Hours 0x0032 100 100 000 Old_age Always - 7052

12 Power_Cycle_Count 0x0032 100 100 000 Old_age Always - 9

167 Unknown_Attribute 0x0000 100 100 000 Old_age Offline - 0

168 Unknown_Attribute 0x0012 100 100 000 Old_age Always - 0

169 Unknown_Attribute 0x0000 100 100 000 Old_age Offline - 0

170 Unknown_Attribute 0x0000 100 100 010 Old_age Offline - 71

172 Unknown_Attribute 0x0032 100 100 000 Old_age Always - 0

173 Unknown_Attribute 0x0000 100 100 000 Old_age Offline - 1966144

181 Program_Fail_Cnt_Total 0x0032 100 100 000 Old_age Always - 0

182 Erase_Fail_Count_Total 0x0000 100 100 000 Old_age Offline - 0

187 Reported_Uncorrect 0x0032 100 100 000 Old_age Always - 0

192 Power-Off_Retract_Count 0x0012 100 100 000 Old_age Always - 4

193 Unknown_SSD_Attribute 0x0000 100 100 000 Old_age Offline - 0

194 Temperature_Celsius 0x0022 057 052 000 Old_age Always - 43 (Min/Max 23/48)

195 Hardware_ECC_Recovered 0x0000 100 100 000 Old_age Offline - 100

196 Reallocated_Event_Count 0x0032 100 100 000 Old_age Always - 0

199 UDMA_CRC_Error_Count 0x0032 100 100 000 Old_age Always - 0

207 Unknown_SSD_Attribute 0x0000 100 100 000 Old_age Offline - 0

218 Unknown_Attribute 0x0032 100 100 000 Old_age Always - 0

231 Unknown_SSD_Attribute 0x0000 099 099 000 Old_age Offline - 99

232 Available_Reservd_Space 0x0013 100 100 000 Pre-fail Always - 0

233 Media_Wearout_Indicator 0x0032 100 100 000 Old_age Always - 20272

241 Total_LBAs_Written 0x0032 100 100 000 Old_age Always - 9897

242 Total_LBAs_Read 0x0032 100 100 000 Old_age Always - 8192

244 Unknown_Attribute 0x0000 100 100 000 Old_age Offline - 30

245 Unknown_Attribute 0x0000 100 100 000 Old_age Offline - 64

246 Unknown_Attribute 0x0000 100 100 000 Old_age Offline - 1007880

SMART Error Log Version: 1

No Errors Logged

SMART Self-test log structure revision number 1

No self-tests have been logged. [To run self-tests, use: smartctl -t]

SMART Selective self-test log data structure revision number 1

SPAN MIN_LBA MAX_LBA CURRENT_TEST_STATUS

1 0 0 Not_testing

2 0 0 Not_testing

3 0 0 Not_testing

4 0 0 Not_testing

5 0 0 Not_testing

Selective self-test flags (0x0):

After scanning selected spans, do NOT read-scan remainder of disk.

If Selective self-test is pending on power-up, resume after 0 minute delay.

root@nuc12:~#Kann man sagen das die NVMe das Problem verursacht?

Bzw. was kann ich noch tun um den Fehler zu finden?

Die NVMe hat gerade einmal einen wareout von 1%.

Das Backup funktioniert mittlerweile gar nicht mehr, hab den Zeitplan jetzt deaktviert.

Das System läuft aber an sich stabil.

Danke schon mal....

Last edited: