Guten Morgen zusammen,

Ich habe ein größeres Problem.

Ich habe ein Cluster mit 2 Nodes eingerichtet. Ich weiss, es kommt öfters die Diskussion hoch, dass man 3 nehmen soll, das ist hier aber irrelevant.

Ich hatte gerade die ersten VMs/Container migriert, da ist der neue Node hardwareseitig kaputt gegangen.

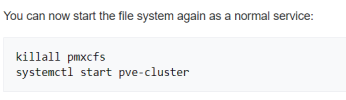

Einfach so ein Cluster auflösen (zweiten Node rausschmeißen) ist ja nicht möglich, zumindest habe ich nichts derartiges gefunden. Es wird dann in den folgenden Artikeln beschrieben, wie man es "manuell" über die Shell machen könnte.

https://pve.proxmox.com/pve-docs/pve-admin-guide.html#pvecm_separate_node_without_reinstall

https://forum.proxmox.com/threads/peoxmox-cluster-auflösen.134172/

https://forum.proxmox.com/threads/removing-cluster-nodes-cluster-not-ready-no-quorum.23622/

https://pve.proxmox.com/wiki/Cluster_Manager

Da wieder mal die Zeit zum gleich durchführen nur teilweise gereicht hat, ist die Prozedur nur halb fertig gewesen.

Jetzt kommt der zweite Hammer:

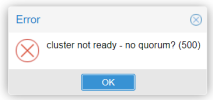

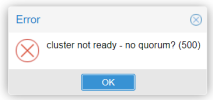

während eines Stromausfalls hat die USV (so wie sie soll) den funktionierenden Node heruntergefahren. Nach dem Neustart ist zwar der Node wieder erreichbar, aber keine der VMs/CTs lässt sich starten. Es kommt immer diese Meldung.

Wäre der PBS nicht ebenfalls eine VM auf dem Node, wäre es halb so schlimm, dann hätte ich den Node einfach neu aufgesetzt und die VMs/CTs aus dem Backup wieder hergestellt.

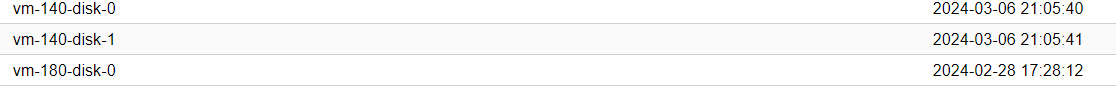

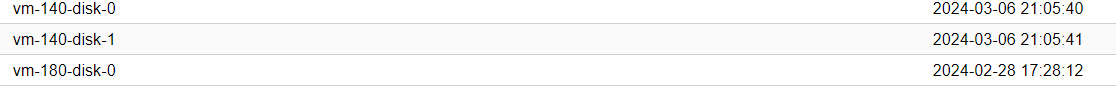

Die VM-Disks (bis auf 2 VMs und 1CT, die nicht so wichtig sind) sollten auf der local-lvm noch vorhanden sein.

ein neuer Node wäre bereits verfügbar.

Hat jemand eine Idee, wie ich den noch vorhandenen Cluster doch noch aufgelöst bekomme bzw. die VMs anderweitig auf den neuen Node bekomme.

Vielen Dank schon mal für eure Hilfe.

Gruß Markus

Ich habe ein größeres Problem.

Ich habe ein Cluster mit 2 Nodes eingerichtet. Ich weiss, es kommt öfters die Diskussion hoch, dass man 3 nehmen soll, das ist hier aber irrelevant.

Ich hatte gerade die ersten VMs/Container migriert, da ist der neue Node hardwareseitig kaputt gegangen.

Einfach so ein Cluster auflösen (zweiten Node rausschmeißen) ist ja nicht möglich, zumindest habe ich nichts derartiges gefunden. Es wird dann in den folgenden Artikeln beschrieben, wie man es "manuell" über die Shell machen könnte.

https://pve.proxmox.com/pve-docs/pve-admin-guide.html#pvecm_separate_node_without_reinstall

https://forum.proxmox.com/threads/peoxmox-cluster-auflösen.134172/

https://forum.proxmox.com/threads/removing-cluster-nodes-cluster-not-ready-no-quorum.23622/

https://pve.proxmox.com/wiki/Cluster_Manager

Da wieder mal die Zeit zum gleich durchführen nur teilweise gereicht hat, ist die Prozedur nur halb fertig gewesen.

Jetzt kommt der zweite Hammer:

während eines Stromausfalls hat die USV (so wie sie soll) den funktionierenden Node heruntergefahren. Nach dem Neustart ist zwar der Node wieder erreichbar, aber keine der VMs/CTs lässt sich starten. Es kommt immer diese Meldung.

Wäre der PBS nicht ebenfalls eine VM auf dem Node, wäre es halb so schlimm, dann hätte ich den Node einfach neu aufgesetzt und die VMs/CTs aus dem Backup wieder hergestellt.

Die VM-Disks (bis auf 2 VMs und 1CT, die nicht so wichtig sind) sollten auf der local-lvm noch vorhanden sein.

ein neuer Node wäre bereits verfügbar.

Hat jemand eine Idee, wie ich den noch vorhandenen Cluster doch noch aufgelöst bekomme bzw. die VMs anderweitig auf den neuen Node bekomme.

Vielen Dank schon mal für eure Hilfe.

Gruß Markus