Hi,

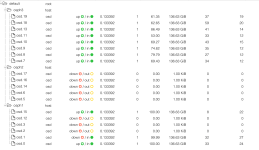

habe leider beim zurückspielen einer VM übersehen, das mein 3er Ceph Cluster schon an der 80% Grenze war, darauf haben die ersten OSDs gesagt sie sind full.

Dann sind allerdings immer mehr OSD down.

Jetzt sind auf einem Node schon alle OSDs down...

Etwas löschen kann ich nicht da das full flag gesetzt ist.

Was kann ich jetzt tun?

habe leider beim zurückspielen einer VM übersehen, das mein 3er Ceph Cluster schon an der 80% Grenze war, darauf haben die ersten OSDs gesagt sie sind full.

Dann sind allerdings immer mehr OSD down.

Jetzt sind auf einem Node schon alle OSDs down...

Etwas löschen kann ich nicht da das full flag gesetzt ist.

Was kann ich jetzt tun?