Hi, ich habe mit dem PVE Wizard unter Disks / Create:ZFS ein ZFS POOL RAID-Z2 = DATEN (4x 4TB erstellt). Danach unter "Datacenter" unter Storage einen ZFS Ordner "DATEN" mit 4TB erstellt. So weit so gut. Es funktioniert auch alles. Nur habe ich jetzt noch freien Speicher den ich irgendwie nicht als "2. Partition" oder "Ordner" erstellt bekomme. Irgendwie ist meine Denkweise nicht korrekte gewesen. Wohl Mist gebaut  . Hätte, wäre, wenn, ... wohl den gesamten Speicher zuordnen müssen ?

. Hätte, wäre, wenn, ... wohl den gesamten Speicher zuordnen müssen ?

zpool status:

root@pve:~# zpool status

pool: DATEN

state: ONLINE

scan: scrub repaired 0B in 0 days 03:29:07 with 0 errors on Sun Nov 8 03:53:08 2020

config:

NAME STATE READ WRITE CKSUM

DATEN ONLINE 0 0 0

raidz2-0 ONLINE 0 0 0

sda ONLINE 0 0 0

sdb ONLINE 0 0 0

sdc ONLINE 0 0 0

sdd ONLINE 0 0 0

errors: No known data errors

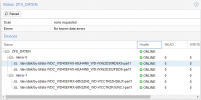

root@pve:~# zfs list

zfs list:

root@pve:~# zfs list

NAME USED AVAIL REFER MOUNTPOINT

DATEN 5.80T 1.02T 140K /DATEN

DATEN/vm-100-disk-0 5.80T 5.20T 1.63T -

Habe leider nichts finden können "Google" was einen ZFS Pool sozusagen "partitionieren" kann. Oder ist das bei ZFS gänzlich anders ?

Verzeiht meine Unwissenheit, bin neu eingestiegen in das Thema "ZFS"

Meine Lektüre: https://www.freebsd.org/doc/de_DE.ISO8859-1/books/handbook/zfs-zfs.html

zpool status:

root@pve:~# zpool status

pool: DATEN

state: ONLINE

scan: scrub repaired 0B in 0 days 03:29:07 with 0 errors on Sun Nov 8 03:53:08 2020

config:

NAME STATE READ WRITE CKSUM

DATEN ONLINE 0 0 0

raidz2-0 ONLINE 0 0 0

sda ONLINE 0 0 0

sdb ONLINE 0 0 0

sdc ONLINE 0 0 0

sdd ONLINE 0 0 0

errors: No known data errors

root@pve:~# zfs list

zfs list:

root@pve:~# zfs list

NAME USED AVAIL REFER MOUNTPOINT

DATEN 5.80T 1.02T 140K /DATEN

DATEN/vm-100-disk-0 5.80T 5.20T 1.63T -

Habe leider nichts finden können "Google" was einen ZFS Pool sozusagen "partitionieren" kann. Oder ist das bei ZFS gänzlich anders ?

Verzeiht meine Unwissenheit, bin neu eingestiegen in das Thema "ZFS"

Meine Lektüre: https://www.freebsd.org/doc/de_DE.ISO8859-1/books/handbook/zfs-zfs.html