Hallo zusammen,

ich bin relativ frisch bei Proxmox und habe gerade auf einem Dell Thin Client Proxmox installiert in der Standard Konfiguration.

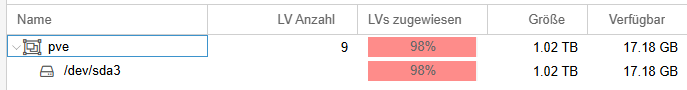

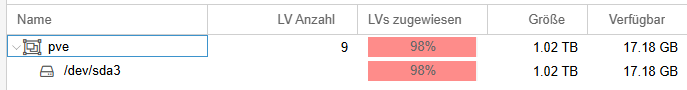

Im Thin Client verbaut ist eine 1TB SSD.

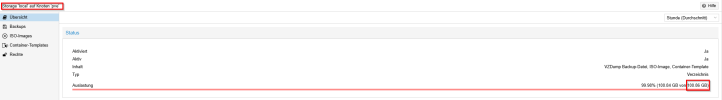

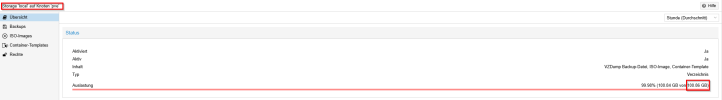

Nun wurde vermutlich bei der Installation für das root (/) Dateisystem nur 96GB zugewiesen.

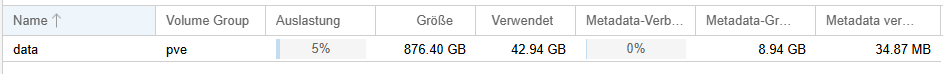

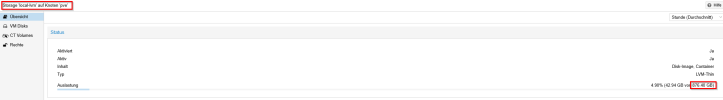

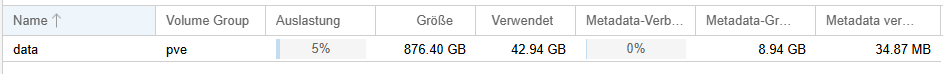

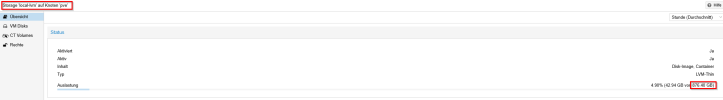

Die restlichen 816 GB wurden dem pve-data LVM Pool zugewiesen.

Dieser ist leider nicht als Laufwerk eingebunden.

Konkret benötige ich aber mehr Speicherplatz auf dem Root oder TMP File System, um VM Images zu entpacken und umzuwandeln.

Wie kann ich entweder den pve-data Bereich als Laufwerk einbinden oder diesen verkleinern und mehr Platz dem Root FS zuweisen?

Ich vermute man soll aus dem LVM Pool nichts direkt einbinden, da Proxmox diesen verwaltet und für Images und Backups nutzt.

In der Oberfläche von Proxmox kann ich auf jeden Fall keinen Speicherplatz umverteilen, da bereits alles verwendet wird.

Hier noch ein paar Screenshots:

Danke im Voraus

shirocko

ich bin relativ frisch bei Proxmox und habe gerade auf einem Dell Thin Client Proxmox installiert in der Standard Konfiguration.

Im Thin Client verbaut ist eine 1TB SSD.

Nun wurde vermutlich bei der Installation für das root (/) Dateisystem nur 96GB zugewiesen.

Die restlichen 816 GB wurden dem pve-data LVM Pool zugewiesen.

Dieser ist leider nicht als Laufwerk eingebunden.

Konkret benötige ich aber mehr Speicherplatz auf dem Root oder TMP File System, um VM Images zu entpacken und umzuwandeln.

Wie kann ich entweder den pve-data Bereich als Laufwerk einbinden oder diesen verkleinern und mehr Platz dem Root FS zuweisen?

Ich vermute man soll aus dem LVM Pool nichts direkt einbinden, da Proxmox diesen verwaltet und für Images und Backups nutzt.

In der Oberfläche von Proxmox kann ich auf jeden Fall keinen Speicherplatz umverteilen, da bereits alles verwendet wird.

Hier noch ein paar Screenshots:

Danke im Voraus

shirocko