Hallo Forum,

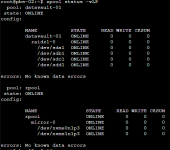

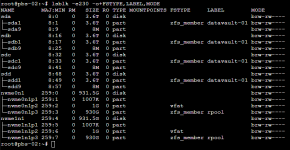

habe ein UGREEN-NAS mit zwei NVMEs ausgestattet und dort den PBS im ZFS-RAID1 installiert. In den HDD-Slots stecken nun 4x 4TB. DIese sind per RAIDZ zu einem Datastore zusammengefasst. Also PimalAuge 3x 4TB=12TB.

Nun soll man ja beim aktuellen ZFS den Datastore erweitern können. Ich habe mal eine fünfte Platte dazugesteckt und versucht über das GUI diesen zu erweitern. Da kommt dann die Meldung, dass ich mindestens zwei Platten zustecken muss. Verstehe ich nicht, da RAID5, welches ja RAIDZ sein soll, auch mit fünf Platten bauen könnte.

Geht das nur über die Console? Wenn ja mit welchen Befehlen? Oder müssen es tatsächlich zwei sein? Ich denke gerade daran, wenn alle 8 Steckplätze voll sind und ich mit 8TB-Platten weitermachen will, sprich die ersten 4TB austausche. Gibts dafür eine Best-Practise-"Anleitung"?

Gruß

Christoph

habe ein UGREEN-NAS mit zwei NVMEs ausgestattet und dort den PBS im ZFS-RAID1 installiert. In den HDD-Slots stecken nun 4x 4TB. DIese sind per RAIDZ zu einem Datastore zusammengefasst. Also PimalAuge 3x 4TB=12TB.

Nun soll man ja beim aktuellen ZFS den Datastore erweitern können. Ich habe mal eine fünfte Platte dazugesteckt und versucht über das GUI diesen zu erweitern. Da kommt dann die Meldung, dass ich mindestens zwei Platten zustecken muss. Verstehe ich nicht, da RAID5, welches ja RAIDZ sein soll, auch mit fünf Platten bauen könnte.

Geht das nur über die Console? Wenn ja mit welchen Befehlen? Oder müssen es tatsächlich zwei sein? Ich denke gerade daran, wenn alle 8 Steckplätze voll sind und ich mit 8TB-Platten weitermachen will, sprich die ersten 4TB austausche. Gibts dafür eine Best-Practise-"Anleitung"?

Gruß

Christoph