Hallo zusammen,

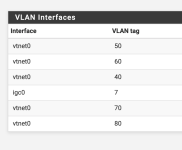

ich habe im Homeoffice Proxmox laufen. Darauf läuft unter anderem eine pfsense, die auch die Einwahl ins Internet macht. Hierfür werden zwei Netzwerinterfaces direkt reingereicht (WAN + LAN und Co) und das LAN per Bridge angebunden.

Das hat mit Proxmox 8.x Jahrelang einwandfrei funktioniert.

Nach dem Update auf 9.05 vor ein paar Tagen kommt es immer wieder (immer nach einigen Std) dazu, dass weder Proxmox noch die pfsense netzwerktechnisch erreichbar ist (ping, ssh,web) usw.

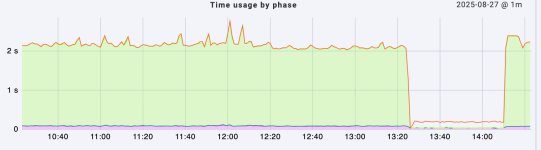

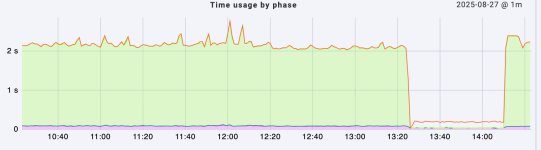

Wie man hier auch durch checkmk sieht, ist das gerade gegen 13:25 Uhr wieder passiert.

Ich muss sagen, dass ich auch aus dem Syslog hier leider nicht schlau werde, was die Ursache sein könnte.

proxmox-boot-tool status

inxi -CN

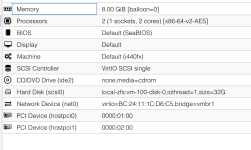

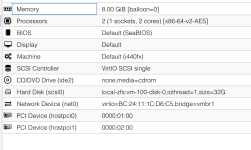

Hier auch noch die Hardwareconfig der pfsense (2.8)

Gestern habe ich noch ein Update auf 9.06 gemacht, allerdings hat dies leider nichts an dem Problem verändert.

Vielleicht hat ja jemand eine Idee oder das gleiche Problem. Vielen Dank!

ich habe im Homeoffice Proxmox laufen. Darauf läuft unter anderem eine pfsense, die auch die Einwahl ins Internet macht. Hierfür werden zwei Netzwerinterfaces direkt reingereicht (WAN + LAN und Co) und das LAN per Bridge angebunden.

Das hat mit Proxmox 8.x Jahrelang einwandfrei funktioniert.

Nach dem Update auf 9.05 vor ein paar Tagen kommt es immer wieder (immer nach einigen Std) dazu, dass weder Proxmox noch die pfsense netzwerktechnisch erreichbar ist (ping, ssh,web) usw.

Wie man hier auch durch checkmk sieht, ist das gerade gegen 13:25 Uhr wieder passiert.

Ich muss sagen, dass ich auch aus dem Syslog hier leider nicht schlau werde, was die Ursache sein könnte.

Aug 27 13:00:34 pve24 systemd[1]: Started check-mk-agent@238-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:00:36 pve24 systemd[1]: check-mk-agent@238-1125-999.service: Deactivated successfully.

Aug 27 13:00:36 pve24 systemd[1]: check-mk-agent@238-1125-999.service: Consumed 1.334s CPU time, 48.4M memory peak.

Aug 27 13:01:34 pve24 systemd[1]: Started check-mk-agent@239-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:01:36 pve24 systemd[1]: check-mk-agent@239-1125-999.service: Deactivated successfully.

Aug 27 13:01:36 pve24 systemd[1]: check-mk-agent@239-1125-999.service: Consumed 1.286s CPU time, 48M memory peak.

Aug 27 13:02:34 pve24 systemd[1]: Started check-mk-agent@240-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:02:36 pve24 systemd[1]: check-mk-agent@240-1125-999.service: Deactivated successfully.

Aug 27 13:02:36 pve24 systemd[1]: check-mk-agent@240-1125-999.service: Consumed 1.280s CPU time, 48.2M memory peak.

Aug 27 13:03:34 pve24 systemd[1]: Started check-mk-agent@241-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:03:36 pve24 systemd[1]: check-mk-agent@241-1125-999.service: Deactivated successfully.

Aug 27 13:03:36 pve24 systemd[1]: check-mk-agent@241-1125-999.service: Consumed 1.284s CPU time, 48.2M memory peak.

Aug 27 13:03:44 pve24 pvedaemon[102540]: <root@pam> successful auth for user 'root@pam'

Aug 27 13:04:34 pve24 systemd[1]: Started check-mk-agent@242-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:04:36 pve24 systemd[1]: check-mk-agent@242-1125-999.service: Deactivated successfully.

Aug 27 13:04:36 pve24 systemd[1]: check-mk-agent@242-1125-999.service: Consumed 1.271s CPU time, 48.2M memory peak.

Aug 27 13:05:34 pve24 systemd[1]: Started check-mk-agent@243-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:05:36 pve24 systemd[1]: check-mk-agent@243-1125-999.service: Deactivated successfully.

Aug 27 13:05:36 pve24 systemd[1]: check-mk-agent@243-1125-999.service: Consumed 1.252s CPU time, 48.3M memory peak.

Aug 27 13:06:34 pve24 systemd[1]: Started check-mk-agent@244-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:06:36 pve24 systemd[1]: check-mk-agent@244-1125-999.service: Deactivated successfully.

Aug 27 13:06:36 pve24 systemd[1]: check-mk-agent@244-1125-999.service: Consumed 1.271s CPU time, 48.3M memory peak.

Aug 27 13:07:34 pve24 systemd[1]: Started check-mk-agent@245-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:07:36 pve24 systemd[1]: check-mk-agent@245-1125-999.service: Deactivated successfully.

Aug 27 13:07:36 pve24 systemd[1]: check-mk-agent@245-1125-999.service: Consumed 1.353s CPU time, 48.3M memory peak.

Aug 27 13:08:34 pve24 systemd[1]: Started check-mk-agent@246-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:08:36 pve24 systemd[1]: check-mk-agent@246-1125-999.service: Deactivated successfully.

Aug 27 13:08:36 pve24 systemd[1]: check-mk-agent@246-1125-999.service: Consumed 1.265s CPU time, 48.2M memory peak.

Aug 27 13:09:34 pve24 systemd[1]: Started check-mk-agent@247-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:09:36 pve24 systemd[1]: check-mk-agent@247-1125-999.service: Deactivated successfully.

Aug 27 13:09:36 pve24 systemd[1]: check-mk-agent@247-1125-999.service: Consumed 1.279s CPU time, 48.2M memory peak.

Aug 27 13:10:34 pve24 systemd[1]: Started check-mk-agent@248-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:10:36 pve24 systemd[1]: check-mk-agent@248-1125-999.service: Deactivated successfully.

Aug 27 13:10:36 pve24 systemd[1]: check-mk-agent@248-1125-999.service: Consumed 1.313s CPU time, 48.5M memory peak.

Aug 27 13:11:34 pve24 systemd[1]: Started check-mk-agent@249-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:11:36 pve24 systemd[1]: check-mk-agent@249-1125-999.service: Deactivated successfully.

Aug 27 13:11:36 pve24 systemd[1]: check-mk-agent@249-1125-999.service: Consumed 1.303s CPU time, 48.2M memory peak.

Aug 27 13:12:34 pve24 systemd[1]: Started check-mk-agent@250-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:12:36 pve24 systemd[1]: check-mk-agent@250-1125-999.service: Deactivated successfully.

Aug 27 13:12:36 pve24 systemd[1]: check-mk-agent@250-1125-999.service: Consumed 1.415s CPU time, 48.2M memory peak.

Aug 27 13:13:34 pve24 systemd[1]: Started check-mk-agent@251-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:13:36 pve24 systemd[1]: check-mk-agent@251-1125-999.service: Deactivated successfully.

Aug 27 13:13:36 pve24 systemd[1]: check-mk-agent@251-1125-999.service: Consumed 1.271s CPU time, 48.3M memory peak.

Aug 27 13:14:34 pve24 systemd[1]: Started check-mk-agent@252-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:14:36 pve24 systemd[1]: check-mk-agent@252-1125-999.service: Deactivated successfully.

Aug 27 13:14:36 pve24 systemd[1]: check-mk-agent@252-1125-999.service: Consumed 1.289s CPU time, 48.2M memory peak.

Aug 27 13:15:34 pve24 systemd[1]: Started check-mk-agent@253-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:15:36 pve24 systemd[1]: check-mk-agent@253-1125-999.service: Deactivated successfully.

Aug 27 13:15:36 pve24 systemd[1]: check-mk-agent@253-1125-999.service: Consumed 1.270s CPU time, 48.1M memory peak.

Aug 27 13:16:34 pve24 systemd[1]: Started check-mk-agent@254-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:16:36 pve24 systemd[1]: check-mk-agent@254-1125-999.service: Deactivated successfully.

Aug 27 13:16:36 pve24 systemd[1]: check-mk-agent@254-1125-999.service: Consumed 1.331s CPU time, 48.5M memory peak.

Aug 27 13:17:01 pve24 CRON[146475]: pam_unix(cron:session): session opened for user root(uid=0) by root(uid=0)

Aug 27 13:17:01 pve24 CRON[146477]: (root) CMD (cd / && run-parts --report /etc/cron.hourly)

Aug 27 13:17:01 pve24 CRON[146475]: pam_unix(cron:session): session closed for user root

Aug 27 13:17:34 pve24 systemd[1]: Started check-mk-agent@255-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:17:36 pve24 systemd[1]: check-mk-agent@255-1125-999.service: Deactivated successfully.

Aug 27 13:17:36 pve24 systemd[1]: check-mk-agent@255-1125-999.service: Consumed 1.255s CPU time, 48.6M memory peak.

Aug 27 13:18:34 pve24 systemd[1]: Started check-mk-agent@256-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:18:36 pve24 systemd[1]: check-mk-agent@256-1125-999.service: Deactivated successfully.

Aug 27 13:18:36 pve24 systemd[1]: check-mk-agent@256-1125-999.service: Consumed 1.264s CPU time, 48.3M memory peak.

Aug 27 13:19:34 pve24 systemd[1]: Started check-mk-agent@257-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:19:36 pve24 systemd[1]: check-mk-agent@257-1125-999.service: Deactivated successfully.

Aug 27 13:19:36 pve24 systemd[1]: check-mk-agent@257-1125-999.service: Consumed 1.282s CPU time, 48.1M memory peak.

Aug 27 13:20:34 pve24 systemd[1]: Started check-mk-agent@258-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:20:36 pve24 systemd[1]: check-mk-agent@258-1125-999.service: Deactivated successfully.

Aug 27 13:20:36 pve24 systemd[1]: check-mk-agent@258-1125-999.service: Consumed 1.294s CPU time, 48.3M memory peak.

Aug 27 13:21:34 pve24 systemd[1]: Started check-mk-agent@259-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:21:36 pve24 systemd[1]: check-mk-agent@259-1125-999.service: Deactivated successfully.

Aug 27 13:21:36 pve24 systemd[1]: check-mk-agent@259-1125-999.service: Consumed 1.335s CPU time, 48.5M memory peak.

Aug 27 13:21:54 pve24 pvedaemon[102995]: <root@pam> successful auth for user 'root@pam'

Aug 27 13:22:34 pve24 systemd[1]: Started check-mk-agent@260-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:22:36 pve24 systemd[1]: check-mk-agent@260-1125-999.service: Deactivated successfully.

Aug 27 13:22:36 pve24 systemd[1]: check-mk-agent@260-1125-999.service: Consumed 1.306s CPU time, 48.3M memory peak.

Aug 27 13:23:34 pve24 systemd[1]: Started check-mk-agent@261-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:23:36 pve24 systemd[1]: check-mk-agent@261-1125-999.service: Deactivated successfully.

Aug 27 13:23:36 pve24 systemd[1]: check-mk-agent@261-1125-999.service: Consumed 1.277s CPU time, 48.1M memory peak.

Aug 27 13:24:34 pve24 systemd[1]: Started check-mk-agent@262-1125-999.service - Checkmk agent (PID 1125/UID 999).

Aug 27 13:24:36 pve24 systemd[1]: check-mk-agent@262-1125-999.service: Deactivated successfully.

Aug 27 13:24:36 pve24 systemd[1]: check-mk-agent@262-1125-999.service: Consumed 1.278s CPU time, 48.1M memory peak.

Aug 27 13:26:54 pve24 pvedaemon[102995]: <root@pam> successful auth for user 'root@pam'

Aug 27 13:34:34 pve24 kernel: CIFS: VFS: \\10.0.100.91 has not responded in 180 seconds. Reconnecting...

Aug 27 13:37:54 pve24 pvedaemon[102540]: <root@pam> successful auth for user 'root@pam'

Aug 27 13:41:23 pve24 pveproxy[110955]: worker exit

Aug 27 13:41:23 pve24 pveproxy[1399]: worker 110955 finished

Aug 27 13:41:23 pve24 pveproxy[1399]: starting 1 worker(s)

Aug 27 13:41:23 pve24 pveproxy[1399]: worker 155005 started

Aug 27 13:42:15 pve24 pveproxy[117025]: worker exit

Aug 27 13:42:15 pve24 pveproxy[1399]: worker 117025 finished

Aug 27 13:42:15 pve24 pveproxy[1399]: starting 1 worker(s)

Aug 27 13:42:15 pve24 pveproxy[1399]: worker 155228 started

Aug 27 13:42:54 pve24 pvedaemon[92659]: <root@pam> successful auth for user 'root@pam'

Aug 27 13:53:54 pve24 pvedaemon[102995]: <root@pam> successful auth for user 'root@pam'

proxmox-boot-tool status

Re-executing '/usr/sbin/proxmox-boot-tool' in new private mount namespace..

System currently booted with uefi

9353-9D68 is configured with: uefi (versions: 6.14.8-2-pve, 6.8.12-13-pve)

inxi -CN

CPU:

Info: quad core model: Intel N100 bits: 64 type: MCP cache: L2: 2 MiB

Speed (MHz): avg: 2619 min/max: 700/3400 cores: 1: 2619 2: 2619 3: 2619 4: 2619

Network:

Device-1: Intel Ethernet I226-V driver: vfio-pci

Device-2: Intel Ethernet I226-V driver: vfio-pci

Device-3: Intel Ethernet I226-V driver: igc

Device-4: Intel Ethernet I226-V driver: igc

Hier auch noch die Hardwareconfig der pfsense (2.8)

Gestern habe ich noch ein Update auf 9.06 gemacht, allerdings hat dies leider nichts an dem Problem verändert.

Vielleicht hat ja jemand eine Idee oder das gleiche Problem. Vielen Dank!

Last edited: