Alles hier ist potentiell gefährlich; du sagst du hast Backups. Ich empfehle dennoch, diesen Node vorher zu evakuieren.

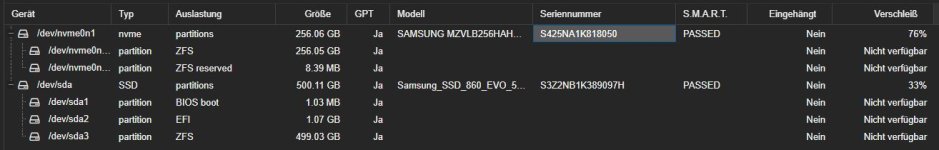

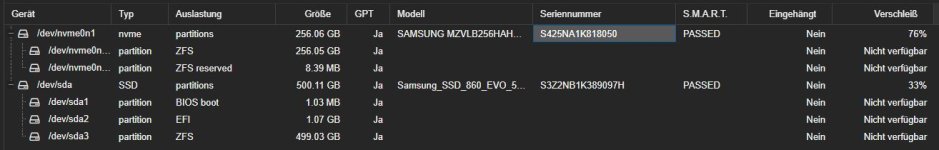

Zunächst zur NVMe: da ist offenbar ein ZFS pool drauf, richtig?

1) nimm deinen externen Adapter und mach aus dem Pool (mit einem einzigen vdev, mit einem einzigen Device) einen temporären Mirror! Das geht nur auf der Kommandozeile, weil "-f" notwendig ist, um so unterschiedlich große Devices zusammen zu kleben. Verwende dazu NICHT /dev/nvme1n1 sondern die Links in

/dev/disk/by-id/

2) lass die Daten resilvern; das kann -je nach Adapter- auch bei einer NVMe etwas dauern; beobachte das per "zpool status"

Danach kannst du den Pool exportieren und die NVMes gegeneinander austauschen. Auch den externen Adapter mit dem nun kleineren Device bitte angekoppelt lassen.

Der Pool muss beim nächsten Neustart unverändert importiert und per "zpool status" sichtbar sein.

Erst dann würde ich die kleinere NVMe per

zpool detach abkoppeln und danach physich entfernen.

Der Pool hat nun immer noch die kleine Größe. Ich suche das jetzt nicht heraus, schau mal nach "autoexpand", setzt das auf "on", exportiere und importiere den Pool erneut. Die neue Größe sollte nun wirksam sein.

Disclaimer: aus dem Stegreif niedergeschrieben --> ohne Garantie ;-)

Dann zur SSD:

Einfach genau so vorgehen (also inklusive der Doppelung per externer Platte) , aber PLUS "bootfähig machen" wie in

https://pve.proxmox.com/pve-docs/pve-admin-guide.html#_zfs_administration - "Changing a failed bootable device" beschrieben.

Die zusätzlichen Punkte "Partitionstabelle kopieren, EFI einrichten und bootfähig machen" sind essentiell!

Viel Glück

----

Oben fehlen etliche Details. Wenn das ein Showstopper für dich ist, ist

@news Empfehlung "neu installieren" eventuell die bessere Wahl.

Was mir bei deinem System nicht gefällt, ist, dass du keinerlei Redundanz hast. ZFS kann einige Zauberkräfte (wie self-healing) nur nutzen, wenn das der Fall wäre.