Also ich habe ca. 10 Rechner heute pve8 auf pve9 gehoben - ging bis auf den letzten, ja so ist das manchmal  alles gut - dachte ich.

alles gut - dachte ich.

Problem er findet beim boot die boot disc nicht. Gab keine Fehler beim upgrade test (pve8to9) und sonst auch noch nie Probleme gehabt mit dem Rechner.

Er versucht wohl zu booten, aber der bootscreen ist in einer zehntel wieder weg und er start das BIOS neu. Gibt es irgendwo ein tutorial was ich evtl. mit der install USB stick etc. machen kann um das zu reparieren. Frisch installieren eher ungern, da ich einige PCI devices und disk neu mappen müsste. Hab mir meinen wichtigsten Rechner nat. für zuletzt am Abend aufgehoben, möchte auch nicht ausschließen, dass ich irgendwo im tran zu schnell config vom paket nehmen geklickt habe (grub?). Mich bisher leider nie mit grub und co auseinander gesetzt.

Backup der config habe ich aber kein komplettes image vom Rechner. Also evtl. doch besser gleich von scratch installieren? sind die pci device mappings etc. in den config /etc/pve...? mit drin? Vermutlich in den nodes, aber passt ("pci ids") das nach neuaufsetzen noch?

So in etwa oder?

Muss mich wohl notgedrungen jetzt mal mit desaster recovery beschäftigen. Ja ich weiss macht man vorher

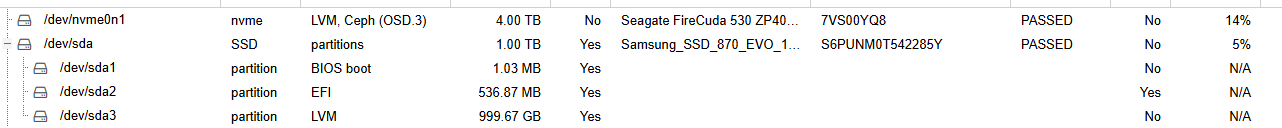

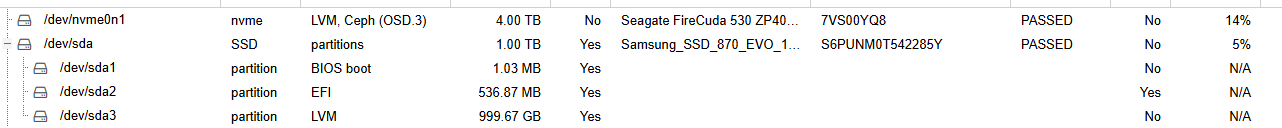

Das bild ist nicht vom betroffenen Rechner, aber der ist ähnlich aufgebaut. MB ist ein Supermicro.

Problem er findet beim boot die boot disc nicht. Gab keine Fehler beim upgrade test (pve8to9) und sonst auch noch nie Probleme gehabt mit dem Rechner.

Er versucht wohl zu booten, aber der bootscreen ist in einer zehntel wieder weg und er start das BIOS neu. Gibt es irgendwo ein tutorial was ich evtl. mit der install USB stick etc. machen kann um das zu reparieren. Frisch installieren eher ungern, da ich einige PCI devices und disk neu mappen müsste. Hab mir meinen wichtigsten Rechner nat. für zuletzt am Abend aufgehoben, möchte auch nicht ausschließen, dass ich irgendwo im tran zu schnell config vom paket nehmen geklickt habe (grub?). Mich bisher leider nie mit grub und co auseinander gesetzt.

Backup der config habe ich aber kein komplettes image vom Rechner. Also evtl. doch besser gleich von scratch installieren? sind die pci device mappings etc. in den config /etc/pve...? mit drin? Vermutlich in den nodes, aber passt ("pci ids") das nach neuaufsetzen noch?

- server aus dem cluster nehmen

- neu installieren

server wieder in den Cluster. - config restore (ich hoffe mal die aus pve8 kann man noch verwenden)

- /etc/network/interfaces

- /etc/pve/nodes/*

- /etc/network/interfaces

- /etc/hosts

- /etc/hostname

- /etc/pve/corosync.conf

- /etc/pve/storage.cfg (falls abweichende lokale Storage-Definitionen)

Muss mich wohl notgedrungen jetzt mal mit desaster recovery beschäftigen. Ja ich weiss macht man vorher

Das bild ist nicht vom betroffenen Rechner, aber der ist ähnlich aufgebaut. MB ist ein Supermicro.

Last edited: