Morgen Fabian,

es sieht so aus, als ob mene Maschine die Konfig ignorieren würde.

Das ist meine Cofig.

agent: 1

balloon: 0

boot: order=scsi0;net0

cores: 6

memory: 145000

meta: creation-qemu=7.2.0,ctime=1688980023

name: truenasscale

net0: virtio=c2:4f:69:21:14:15,bridge=vmbr0

numa: 0

ostype: l26

scsi0: local-lvm:vm-100-disk-0,iothread=1,size=64G

scsihw: virtio-scsi-single

hostpci0: 0000:84:00

smbios1: uuid=40d8dd69-1400-45a2-8d27-80f40c00dd64

sockets: 2

tags:

vmgenid: 76e33ecd-4ea2-4b3c-b2a2-15a673b2d769

qm start 100 --timeout 140

jul 18 09:09:41 hotstandby pvestatd[15875]: status update time (8.626 seconds)

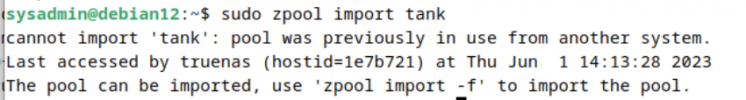

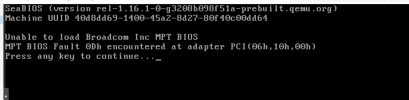

Jul 18 09:09:42 hotstandby qm[561818]: start failed: command '/usr/bin/kvm -id 100 -name 'truenasscale,debug-threads=on' -no-shutdown -chardev 'socket,id=qmp,path=/var/run/qemu-server/100.qmp,server=on,wait=off' -mon 'chardev=qmp,mode=control' -chardev 'socket,id=qmp-event,path=/var/run/qmeventd.sock,reconnect=5' -mon 'chardev=qmp-event,mode=control' -pidfile /var/run/qemu-server/100.pid -daemonize -smbios 'type=1,uuid=40d8dd69-1400-45a2-8d27-80f40c00dd64' -smp '12,sockets=2,cores=6,maxcpus=12' -nodefaults -boot 'menu=on,strict=on,reboot-timeout=1000,splash=/usr/share/qemu-server/bootsplash.jpg' -vnc 'unix:/var/run/qemu-server/100.vnc,password=on' -cpu kvm64,enforce,+kvm_pv_eoi,+kvm_pv_unhalt,+lahf_lm,+sep -m 145000 -object 'iothread,id=iothread-virtioscsi0' -device 'pci-bridge,id=pci.1,chassis_nr=1,bus=pci.0,addr=0x1e' -device 'pci-bridge,id=pci.2,chassis_nr=2,bus=pci.0,addr=0x1f' -device 'pci-bridge,id=pci.3,chassis_nr=3,bus=pci.0,addr=0x5' -device 'vmgenid,guid=76e33ecd-4ea2-4b3c-b2a2-15a673b2d769' -device 'piix3-usb-uhci,id=uhci,bus=pci.0,addr=0x1.0x2' -device 'usb-tablet,id=tablet,bus=uhci.0,port=1' -device 'vfio-pci,host=0000:84:00.0,id=hostpci0,bus=pci.0,addr=0x10' -device 'VGA,id=vga,bus=pci.0,addr=0x2' -chardev 'socket,path=/var/run/qemu-server/100.qga,server=on,wait=off,id=qga0' -device 'virtio-serial,id=qga0,bus=pci.0,addr=0x8' -device 'virtserialport,chardev=qga0,name=org.qemu.guest_agent.0' -iscsi 'initiator-name=iqn.1993-08.org.debian:01:d9ed19d296b' -device 'virtio-scsi-pci,id=virtioscsi0,bus=pci.3,addr=0x1,iothread=iothread-virtioscsi0' -drive 'file=/dev/pve/vm-100-disk-0,if=none,id=drive-scsi0,format=raw,cache=none,aio=io_uring,detect-zeroes=on' -device 'scsi-hd,bus=virtioscsi0.0,channel=0,scsi-id=0,lun=0,drive=drive-scsi0,id=scsi0,bootindex=100' -netdev 'type=tap,id=net0,ifname=tap100i0,script=/var/lib/qemu-server/pve-bridge,downscript=/var/lib/qemu-server/pve-bridgedown,vhost=on' -device 'virtio-net-pci,mac=c2:4f:69:21:14:15,netdev=net0,bus=pci.0,addr=0x12,id=net0,rx_queue_size=1024,tx_queue_size=1024,bootindex=101' -machine 'type=pc+pve0'' failed: got timeout