root@proxmox2:~# systemd-analyze critical-chain

The time after the unit is active or started is printed after the "@" character.

The time the unit takes to start is printed after the "+" character.

graphical.target @51.074s

└─multi-user.target @51.074s

└─pve-guests.service @21.202s +29.871s

└─pve-ha-lrm.service @20.675s +524ms

└─pveproxy.service @19.720s +951ms

└─pvedaemon.service @18.965s +752ms

└─corosync.service @18.555s +407ms

└─pve-cluster.service @17.500s +1.025s

└─rrdcached.service @17.390s +104ms

└─remote-fs.target @17.384s

└─mnt-pve-NFS_SSD_500GB.mount @32.251s

└─remote-fs-pre.target @17.383s

└─nfs-server.service @16.255s +1.126s

└─nfs-mountd.service @16.137s +112ms

└─network.target @16.136s

└─networking.service @14.731s +1.403s

└─openvswitch-switch.service @14.195s +534ms

└─openvswitch-nonetwork.service @13.745s +447ms

└─apparmor.service @13.720s +24ms

└─local-fs.target @13.719s

└─etc-pve.mount @17.526s

└─local-fs-pre.target @936ms

└─lvm2-monitor.service @141ms +767ms

└─dm-event.service @206ms

└─dm-event.socket @133ms

└─-.mount @125ms

└─system.slice @125ms

└─-.slice @125ms

root@proxmox2:~# journalctl -u lvm2-monitor.service

-- Logs begin at Sun 2020-12-06 16:23:30 CET, end at Mon 2020-12-07 18:45:00 CET. --

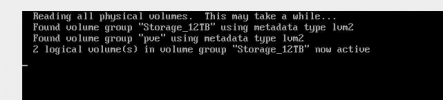

Dec 06 16:23:30 proxmox2 lvm[729]: 4 logical volume(s) in volume group "Storage_12TB" monitored

Dec 06 16:23:30 proxmox2 lvm[729]: 9 logical volume(s) in volume group "pve" monitored

Dec 06 16:23:31 proxmox2 systemd[1]: Started Monitoring of LVM2 mirrors, snapshots etc. using dmeventd or progress polling.