und die Sicherung ist nicht auf dem PBS sichtbar das ich sie löschen könnte.

Einen wunderschönen guten Morgen, ich habe da mal erneut ein klitzekleines Problemchen...

Also ich habe vorgestern Abend mal auf einem meiner 2 ProxmoxHosts ein Vollbackup angeworfen. (mit den folgenden befehl)

gestern habe ich festgestellt das der PBS zu 100% vollgelaufen ist, und habe daraufhin das Backup abgebrochen auf dem Host.

Leider habe ich auf dem PBS keine Host Sicherung gefunden, aber das System ist trotzdem zu 100% belegt

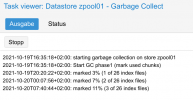

Ich habe dann einmal auf dem PBS --> Datastore --> zpool01 --> Prune & GC --> "Garbage Collection" gestartet, in der Hoffnung das damit die abgebrochenen Sicherung gelöscht wird...nunja, jetzt nach ca. 16 Stunden zeigt mir der Task das folgende an.

Er scheint ja noch zu laufen, aber bringt das wirklich wieder freien speicher ?, also wird damit das abgebrochene Host-Backup entfernt und der Speicher wieder frei gegeben ?

Ansonsten bin ich für Vorschläge offen

Grüße

Foxi

Einen wunderschönen guten Morgen, ich habe da mal erneut ein klitzekleines Problemchen...

Also ich habe vorgestern Abend mal auf einem meiner 2 ProxmoxHosts ein Vollbackup angeworfen. (mit den folgenden befehl)

Code:

proxmox-backup-client backup pve_sda.img:/dev/sda --repository pbs.home.net:zpool01 --backup-type host --crypt-mode nonegestern habe ich festgestellt das der PBS zu 100% vollgelaufen ist, und habe daraufhin das Backup abgebrochen auf dem Host.

Leider habe ich auf dem PBS keine Host Sicherung gefunden, aber das System ist trotzdem zu 100% belegt

Ich habe dann einmal auf dem PBS --> Datastore --> zpool01 --> Prune & GC --> "Garbage Collection" gestartet, in der Hoffnung das damit die abgebrochenen Sicherung gelöscht wird...nunja, jetzt nach ca. 16 Stunden zeigt mir der Task das folgende an.

Er scheint ja noch zu laufen, aber bringt das wirklich wieder freien speicher ?, also wird damit das abgebrochene Host-Backup entfernt und der Speicher wieder frei gegeben ?

Ansonsten bin ich für Vorschläge offen

Grüße

Foxi