Guten Morgen

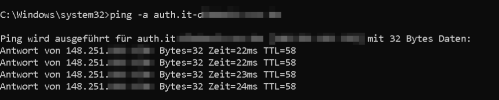

Ping geht problemlos durch.

View attachment 66589

Das Journal ist ja endlos lang. Ich habe es daher mal umgedreht und den Teil gepostet, der unmittelbar nach dem Bekanntwerden des Fehlers passierte. Morgens um 7:00 Uhr, als wir die Maschine neu gestartet haben, das Backup zurückgespielt haben etc.

Code:

Apr 09 07:05:04 Keycloak2 systemd-journald[42]: Journal started

Apr 09 07:05:04 Keycloak2 systemd-journald[42]: Runtime Journal (/run/log/journal/7>

Apr 09 07:05:04 Keycloak2 systemd-journald[42]: Time spent on flushing to /var/log/>

Apr 09 07:05:04 Keycloak2 systemd-journald[42]: System Journal (/var/log/journal/71>

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Flush Journal to Persistent Storage.>

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Create Static Device Nodes in /dev.

Apr 09 07:05:04 Keycloak2 systemd[1]: Condition check resulted in Rule-based Manage>

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Set the console keyboard layout.

Apr 09 07:05:04 Keycloak2 systemd[1]: Reached target Preparation for Local File Sys>

Apr 09 07:05:04 Keycloak2 systemd[1]: Reached target Local File Systems.

Apr 09 07:05:04 Keycloak2 keyboard-setup.sh[53]: Couldn't get a file descriptor ref>

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Load AppArmor profiles...

Apr 09 07:05:04 Keycloak2 keyboard-setup.sh[56]: Couldn't get a file descriptor ref>

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Set console font and keymap...

Apr 09 07:05:04 Keycloak2 keyboard-setup.sh[57]: Couldn't get a file descriptor ref>

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Set Up Additional Binary Formats...

Apr 09 07:05:04 Keycloak2 keyboard-setup.sh[58]: setupcon: We are not on the consol>

Apr 09 07:05:04 Keycloak2 systemd[1]: Condition check resulted in Store a System To>

Apr 09 07:05:04 Keycloak2 systemd[1]: Condition check resulted in Commit a transien>

Apr 09 07:05:04 Keycloak2 systemd[1]: Condition check resulted in Merge System Exte>

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Uncomplicated firewall...

Apr 09 07:05:04 Keycloak2 apparmor.systemd[75]: Restarting AppArmor

Apr 09 07:05:04 Keycloak2 apparmor.systemd[75]: Reloading AppArmor profiles

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished nftables.

Apr 09 07:05:04 Keycloak2 apparmor.systemd[92]: Skipping profile in /etc/apparmor.d>

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Uncomplicated firewall.

Apr 09 07:05:04 Keycloak2 systemd[1]: Reached target Preparation for Network.

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Network Configuration...

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Set Up Additional Binary Formats.

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Set console font and keymap.

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Load AppArmor profiles.

Apr 09 07:05:04 Keycloak2 systemd-networkd[83]: Failed to increase receive buffer s>

Apr 09 07:05:04 Keycloak2 systemd-networkd[83]: lo: Link UP

Apr 09 07:05:04 Keycloak2 systemd-networkd[83]: lo: Gained carrier

Apr 09 07:05:04 Keycloak2 systemd-networkd[83]: Enumeration completed

Apr 09 07:05:04 Keycloak2 systemd[1]: Started Network Configuration.

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Wait for Network to be Configured...

Apr 09 07:05:04 Keycloak2 systemd-networkd[83]: eth0: Link UP

Apr 09 07:05:04 Keycloak2 systemd-networkd[83]: eth0: Gained carrier

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Flush Journal to Persistent Storage.

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Create Volatile Files and Directorie>

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Create Volatile Files and Directorie>

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Network Name Resolution...

Apr 09 07:05:04 Keycloak2 systemd[1]: Condition check resulted in Network Time Sync>

Apr 09 07:05:04 Keycloak2 systemd[1]: Reached target System Time Set.

Apr 09 07:05:04 Keycloak2 systemd[1]: Starting Record System Boot/Shutdown in UTMP.>

Apr 09 07:05:04 Keycloak2 cron[99]: (CRON) INFO (pidfile fd = 3)

Apr 09 07:05:04 Keycloak2 systemd[1]: Finished Record System Boot/Shutdown in UTMP.

Apr 09 07:05:04 Keycloak2 cron[99]: (CRON) INFO (Running @reboot jobs)

Apr 09 07:05:04 Keycloak2 systemd[1]: Reached target System Initialization.

Apr 09 07:05:04 Keycloak2 rsyslogd[104]: imuxsock: Acquired UNIX socket '/run/syste>

Apr 09 07:05:04 Keycloak2 systemd[1]: Started Daily apt download activities.

Apr 09 07:05:04 Keycloak2 rsyslogd[104]: imklog: cannot open kernel log (/proc/kmsg>

Apr 09 07:05:04 Keycloak2 systemd[1]: Started Daily apt upgrade and clean activitie>

systemctl status liefert folgende Meldung:

Code:

Keycloak2

State: running

Jobs: 0 queued

Failed: 0 units

Since: Tue 2024-04-09 07:05:03 UTC; 1 week 2 days ago

CGroup: /

├─.lxc

│ ├─176940 /bin/bash

│ ├─176948 systemctl status

│ └─176949 less

├─init.scope

│ └─1 /sbin/init

└─system.slice

├─containerd.service

│ ├─ 124 /usr/bin/containerd

│ ├─ 757 /usr/bin/containerd-shim-runc-v2 -namespace moby -id bae5d4f9>

│ ├─ 917 /usr/bin/containerd-shim-runc-v2 -namespace moby -id f5fa0a99>

│ └─1124 /usr/bin/containerd-shim-runc-v2 -namespace moby -id 8479ea2d>

├─systemd-networkd.service

│ └─83 /lib/systemd/systemd-networkd

├─cron.service

│ └─99 /usr/sbin/cron -f -P

├─docker-8479ea2d26f124848fd2a08649a6998fe0921ad89866dd19790f2cefb5e06>

│ ├─ 1145 /bin/bash /app/start.sh

│ ├─ 1515 /bin/bash /app/letsencrypt_service

│ ├─ 1516 docker-gen -watch -notify /app/signal_le_service -wait 5s:2>

│ └─176897 sleep 3600

├─docker-f5fa0a9938da186886f9c44d2c901dcb2e2f1cb4c1b04540c8f72cf6102ec>

│ ├─ 940 postgres

│ ├─1115 postgres: checkpointer

│ ├─1116 postgres: background writer

│ ├─1980 postgres: walwriter

│ ├─1981 postgres: autovacuum launcher

│ └─1982 postgres: logical replication launcher

├─docker.service

│ ├─136 /usr/bin/dockerd -H fd:// --containerd=/run/containerd/contain>

│ ├─686 /usr/bin/docker-proxy -proto tcp -host-ip 0.0.0.0 -host-port 4>

│ ├─692 /usr/bin/docker-proxy -proto tcp -host-ip :: -host-port 443 -c>

│ ├─706 /usr/bin/docker-proxy -proto tcp -host-ip 0.0.0.0 -host-port 8>

│ └─712 /usr/bin/docker-proxy -proto tcp -host-ip :: -host-port 80 -co>

├─networkd-dispatcher.service

│ └─103 /usr/bin/python3 /usr/bin/networkd-dispatcher --run-startup-tr>

├─systemd-journald.service

│ └─42 /lib/systemd/systemd-journald

├─rsyslog.service

│ └─104 /usr/sbin/rsyslogd -n -iNONE

├─console-getty.service

│ └─125 /sbin/agetty -o -p -- \u --noclear --keep-baud console 115200,>

├─system-postfix.slice

│ └─postfix@-.service

│ ├─ 303 /usr/lib/postfix/sbin/master -w

│ ├─ 1978 qmgr -l -t unix -u

│ └─176528 pickup -l -t unix -u -c

├─systemd-resolved.service

│ └─96 /lib/systemd/systemd-resolved

├─docker-bae5d4f919d8bab957ff9161236573b4ae4e999ef0e664843349d1d004ac4>

│ ├─ 778 forego start -r

│ ├─ 875 docker-gen -watch -notify nginx -s reload /app/nginx.tmpl /et>

│ ├─ 879 nginx: master process nginx -g daemon off;

│ ├─2147 nginx: worker process

│ ├─2148 nginx: worker process

│ ├─2149 nginx: worker process

│ ├─2150 nginx: worker process

│ ├─2151 nginx: worker process

│ ├─2152 nginx: worker process

│ ├─2154 nginx: worker process

│ ├─2155 nginx: worker process

│ ├─2156 nginx: worker process

│ ├─2157 nginx: worker process

│ ├─2158 nginx: worker process

│ └─2159 nginx: worker process

├─system-container\x2dgetty.slice

│ ├─container-getty@2.service

│ │ └─127 /sbin/agetty -o -p -- \u --noclear --keep-baud tty2 115200,3>

│ └─container-getty@1.service

│ └─126 /sbin/agetty -o -p -- \u --noclear --keep-baud tty1 115200,3>

├─dbus.service

│ └─100 @dbus-daemon --system --address=systemd: --nofork --nopidfile >

└─systemd-logind.service

└─105 /lib/systemd/systemd-logind

Eine Fehlermeldung fällt auf:

Code:

Apr 19 06:24:00 Keycloak2 sshd[176929]: error: kex_exchange_identification: Connect>

Also doch ein Zertifikatsproblem?

Ja, wir setzten einen Reverse Proxy ein.